Categoría: informatica en medicina

La gestión del conocimiento en medicina: a la búsqueda de la información perdida (2002)

parte de Bravo R.La gestión del conocimiento en Medicina: a la búsqueda de la información perdida.ANALES Sis San Navarra 2002; 25 (3):255-272 DOI: https://doi.org/10.23938/ASSN.0802

UN EJEMPLO Y UNA CONCLUSIÓN APRESURADA

El Dr. Beltrán, médico de familia del centro de salud “Conocimiento integrado”, se dispone a comenzar su jornada de trabajo; mientras enciende su ordenador, dirige su mirada a su vacía mesa de trabajo, que solo alberga un teclado inalámbrico de reducidas proporciones y un ratón aún más pequeño. Una vez que la pantalla empieza a parpadear, recibe el aviso de que tiene nuevos mensajes de correo electrónico en su buzón.

El primero de ellos es de la gerencia de su área, que le informa de los cambios de horarios en las consultas de especialistas a los que suele derivar a sus pacientes; le echa un vistazo rápido y no le presta mayor atención, sabedor de que esta información está actualizada en la página web de la intranet de su institución junto a otra información útil, como los tiempos de espera para conseguir cita y los teléfonos y correos electrónicos de los especialistas con los que suele mantener una fluida relación.

El segundo mensaje es de su bibliotecario; como todos los lunes, le informa de los artículos de interés clínico que se han publicado en la semana anterior en las revistas más importantes de su especialidad. El conciso resumen le permite leerlo rápidamente, y sabe que en caso de que uno de los artículos le interese, puede acceder a un resumen más amplio o incluso al texto completo con solo apretar un botón. Está contento con este servicio y más con la última novedad: la unidad de epidemiología clínica del hospital ofrece evaluaciones críticas resumidas de los artículos más importantes y de aquellos que son solicitados por un número suficiente de clínicos. Le encanta porque, aunque es consciente de su importancia, a estos aspectos metodológicos siempre le sonaron un poco a chino.

El tercer mensaje es del laboratorio; le informa del resultado del hemograma y la prueba de Paul-Bunnell en un joven con adenopatías que el Dr. Beltrán vio el día anterior. Normalmente, los resultados se envían directamente por la red y se integran en el historial de cada paciente, pero en este caso el Dr. Beltran había indicado que además se lo comunicaran directamente. Estaba preocupado; el chaval llevaba más de veinte días con adenopatías de gran tamaño, no tenía fiebre ni faringitis, y el pensamiento de una enfermedad más grave había pasado por su cabeza mientras lo auscultaba. Estuvo tentado de pedir una batería de pruebas complementarias, pero tras escribir los síntomas y signos del muchacho y apretar el botón de ayuda diagnóstica, su ordenador le sugirió que lo hiciera de forma escalonada, comenzando con un hemograma simple y serología para el virus de Epstein Barr. Esta recomendación se apoyaba en un texto sacado de una de sus fuentes favoritas de información y se complementaba con enlaces a artículos de revisión clínica sobre el tema. En la misma pantalla aparecía el número de casos que se habían diagnosticado en su área sanitaria, incluyendo las características clínicas porcentuales de estos casos. En ese momento fue cuando pensó que merecía la pena el trabajo de codificar cada actuación que llevaba a cabo en su consulta. Tras leer el mensaje, se dispuso a escribir un correo electrónico a la madre del joven, donde le relataba los resultados del análisis, le tranquilizaba sobre el problema y le adjuntaba un archivo con información para pacientes sobre la mononucleosis infecciosa, citándole para revisión días más tarde.

Ya habían pasado unos diez minutos y el primer paciente del Dr. Beltrán esperaba en la puerta; era un diabético conocido, que minutos antes aguantaba pacientemente el interrogatorio al que la enfermera le estaba sometiendo como parte de su revisión semestral. Con un cuestionario estructurado de preguntas y actuaciones, la enfermera realizaba su trabajo de forma amable pero rigurosa; sabía que el paciente no estaba cumpliendo con el tratamiento prescrito, al menos no recogía las recetas suficientes para cumplirlo como estaba establecido; además, el peso no bajaba. La enfermera del Dr. Beltrán decidió repasar qué actuaciones podría llevar a cabo para solventar este problema; para ello no tenía más que buscar en la base de datos de efectividad clínica en enfermería que estaba disponible en Internet. Aunque llevaba algo de tiempo, no le importaba, ya que el paciente debía ver también al doctor. El programa le había indicado la necesidad de una derivación al médico cuando se recogieron cifras tensiónales por encima de las esperadas en un paciente diabético en dos ocasiones consecutivas.

Para el Dr. Beltrán no está claro si tenía que iniciar tratamiento y qué tratamiento es el más indicado, por lo que decide consultar las guías automatizadas sobre hipertensión. No dispone de mucho tiempo y por eso aprecia el mensaje breve y rotundo que le aparece en su pantalla: “Todos los diabéticos con cifras tensiónales por encima de …/… deben ser controlados. El tratamiento recomendado es un IECA. Nivel de evidencia II”. Una vez que observa la información de las posibles interacciones con la medicación actual, alergias o efectos indeseables previos y cuál de las alternativas entre las diferentes marcas y tipos de IECAs es más costo efectiva. El Dr. Beltrán extiende la receta que lleva incorporada información específica sobre la administración del medicamento, despide a su paciente y piensa que hoy será un largo día……………….

Conclusión

Para finalizar y parafraseando a Wyatt * podemos decir que el futuro de la gestión del conocimiento en sanidad es brillante. Tenemos ya la tecnología adecuada en forma de Internet, y un armazón intelectual de la mano de la atención sanitaria basada en la evidencia. También disponemos de profesionales de la gestión del conocimiento y las herramientas informáticas que ayudan a manejar el conocimiento explícito se han desarrollado y refinado. Solo nos falta un poco de entusiasmo imaginativo y un presupuesto suficiente, esperemos que nuestros gestores, si no nos pueden dar algo de lo primero, al menos aporten una parte de lo segundo.

* Wyatt JC. Management of explicit and tacit knowledge. J R Soc Med. 2001 Jan;94(1):6-9.

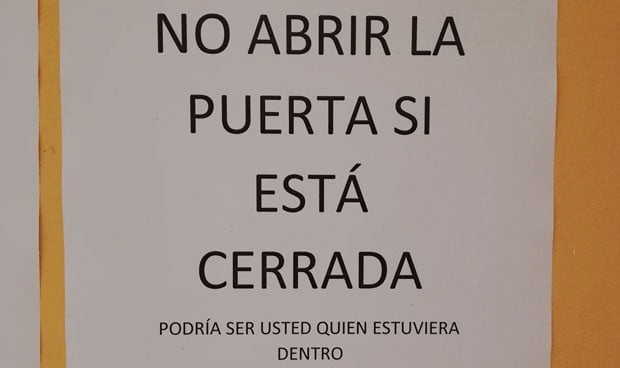

Telemedicina en AP: ni estuvo, ni está, ni se le espera.

Una de las mentes más lúcidas de la atención primaria española me contó hace tiempo que, tras un cambio en la organización de las consultas en su centro de salud, se encontraron con un resultado inesperado: las salas de espera permanecían vacías la mayor parte del tiempo. Ese vacío, lejos de interpretarse como eficiencia, generaba malestar en algunos pacientes, acostumbrados a salas repletas, que veían la ausencia de gente como un signo de incompetencia o de poco trabajo por parte de los profesionales. Para corregir esa percepción, decidieron entregar, junto con la cita, un número de orden en el que además se indicaba cuántos pacientes habían sido atendidos en cada consulta.

Con frecuencia se leen quejas similares en redes sociales: “Una semana esperando para que me vean y cuando llego, el centro está vacío”. No sorprende esta reacción. Durante la pandemia, una gerente de atención primaria, poco competente, llegó a afirmar que el verdadero trabajo se hacía en los hospitales, porque cuando visitaba los centros de salud veía las salas vacías.

La repuesta es casi comprensible, salvo en el caso de la gerente. Si alguien ha crecido viendo al maquinista echar carbón a la locomotora de un tren de vapor, cuando el tren pasa a ser eléctrico y deja de verlo, tiende a pensar que el maquinista ya no hace nada.

Hace unos días El Confidencial publicó una noticia con un título alarmante ilustrada con la fotografía de una sala de espera vacía y, al fondo, un médico frente al ordenador. El texto sostenía que las “teleconsultas” médicas, presentadas durante la pandemia como el gran salto hacia la medicina del futuro, han terminado ocupando un papel muy limitado en los centros de salud españoles. Según la noticia, estas apenas suponen alrededor de un 15% de la jornada de los médicos de familia y se usan casi siempre para tareas administrativas: renovar recetas, resolver dudas sencillas o gestionar algunas bajas laborales por teléfono.

Se proponen varias explicaciones para esta infrautilización, pero, a mi juicio, el problema no es la tecnología, ni que los pacientes prefieran siempre la consulta presencial, ni que la telemedicina tenga poca capacidad resolutiva, ni siquiera la falta de protocolos o de planificación. Las causas de que la telemedicina no se use, o se use de forma poco adecuada tras el impulso inicial de la pandemia, tienen mucho más que ver con la organización piramidal, jerárquica y poco inteligente de la atención primaria. Con una gerencia sin iniciativa, que por un lado demuestra escasa capacidad organizativa y, por otro, interviene hasta el detalle en las agendas de los médicos, fragmentándolas en tramos de diez minutos. A ello se suma un grupo de profesionales acomodados y temerosos de ofrecer una mayor accesibilidad a los pacientes.

En la noticia se mezclan cosas distintas: la simple llamada telefónica para resolver gestiones puntuales o burocráticas, que muchos centros de salud autoorganizados ya utilizaban, con auténticas consultas telefónicas y videoconsultas. Incluso el representante médico entrevistado añadía al mismo saco las interconsultas entre especialistas y la monitorización a distancia, contribuyendo al batiburrillo conceptual.

La telemedicina, en todas sus variantes, mostró durante la pandemia su enorme potencial tanto asistencial como organizativo, y distintas experiencias aisladas, casi siempre al margen del beneplácito de las gerencias, lo confirmaron. Sin embargo, las instituciones sanitarias no han sabido incorporarla de forma sensata y estable. Han hecho un giro “lampedusiano”: cambiar algunas cosas para que, en el fondo, todo siga igual, sometiendo a la telemedicina a un descrédito del que costará trabajo recuperarse.

Eso sí, las salas de espera han vuelto a llenarse.

OpenAI descubre que la asistencia sanitaria tiene problemas y se ofrece como solución.

Tras la publicación de un documento de OpenAI sobre inteligencia artificial (IA) y asistencia sanitaria. John Ferguson, cirujano americano radicado en Hawaii, hace una lúcida y mordaz crítica del documento en particular y del empeño de las compañías punteras de IA para introducirse en el campo de la asistencia sanitaria. Gracias a Julio Bonis, que nos avisó sobre esta entrada, y al generoso permiso del Dr Ferguson traducimos su entrada original de LinkedIn.

Traduccion de OpenAI Discovers Healthcare Has Problems, Offers to Be the Solution por John Ferguson, MD, FACS President-Elect, ABFCS | Surgeon Solving AI Hallucination in High-Stakes Domains | EdAI CEO | Co-Chair Written Exam Committees |

OpenAI descubre que los servicios de atención sanitaria tienen problemas y se ofrece como solución. o: Cómo citar tu propia precisión del 31% como un «diagnóstico preciso»

OpenAI acaba de publicar un documento de 18 páginas titulado «La IA como aliada de la asistencia sanitaria». Lo he leído para que no tengas que hacerlo. Mi tensión arterial está bien. La he comprobado yo mismo, sin ChatGPT, porque tengo 10 000 millones de neuronas sensoriales y un tensiómetro.

Te lo resumo: los estadounidenses están preocupados por la asistencia sanitaria. La asistencia sanitaria es cara. Los hospitales rurales están cerrando. La gente envía mensajes a ChatGPT sobre seguros de salud. Por lo tanto, la IA debería encargarse del diagnóstico.

Si ese salto lógico te ha dejado atónito, es que estás prestando atención.

El juego de los números

OpenAI quiere que sepas que 40 millones de personas utilizan ChatGPT cada día para preguntas sobre salud. Uno de cada cuatro usuarios pregunta sobre salud cada semana. Casi 600 000 mensajes provienen de reguniones geográficas consideradas «desiertos hospitalarios».

¿Sabes qué tiene también mucho tráfico? WebMD. Las secciones de comentarios de los blogs de madres. Ese tipo de YouTube que cree que se puede curar la diabetes con canela.

El volumen de trafico no equivale a calidad.

Pero aquí es donde se pone interesante. Escondido en la página 10, OpenAI cita OpenEvidence, una plataforma construida usando sus modelos, como apoyo para «diagnósticos precisos verificados a partir de guías de práctica clínica».

OpenEvidence. El sistema de 210 millones de dólares con 400 000 médicos usuarios. 100 % de acierto en los exámenes para una autorización para practicar la medicina (medical licensing exams).

31-41% de acierto en las preguntas que regulan el acceso a las distintas especialidades.

Lo probé yo mismo. Les hice un examen a libro abierto, solo con preguntas en las que tenían acceso directo al material de referencia. Sin asimetría de información. Con todas las ventajas.

Obtuvieron una puntuación inferior al umbral de aprobado.

Próximamente compartiré la metodología y los resultados completos. Pero «preciso» no es la palabra que yo utilizaría para describirlos.

El señuelo y el cambio

El documento realiza un truco de prestidigitación que ya he visto antes:

Paso 1: Establecer un problema real. «Los seguros son confusos. Los hospitales rurales están cerrando. La gente no puede conseguir citas».

Paso 2: Mostrar cómo la IA ayuda con ese problema. «¡ChatGPT ayuda a la gente a entender sus facturas médicas! ¡A entender las condiciones de los seguros! ¡A prepararse para las citas médicas!».

Paso 3: Pasar a un problema completamente diferente. «Y además realiza diagnósticos precisos».

Esto es como decir: «La gente tiene hambre. Los food trucks son populares. Por lo tanto, déjame operarte de apendicitis desde un food truck.

El problema de acceso a la atención sanitaria es real. La IA que ayuda a la gente a descifrar la jerga de los seguros médicos es realmente útil. Pero «explicar la prima y condiciones de tu seguro de salud» y «diagnosticar tu dolor de pecho» no son la misma cosa, tienen el mismo perfil de riesgo ni la misma estructura de responsabilidad.

OpenAI lo sabe. Cuentan con que tú no te des cuenta.

El complejo industrial de las anécdotas

Cada pocas páginas, una historia conmovedora. La madre de Ayrin en Indonesia. La reclamación al seguro de Rich Kaplan. El Dr. Albers en la Montana rural.

¿Sabes qué tienen en común estas historias? La IA tenía razón.

¿Sabes qué falta? Todas las historias en las que no la tenía.

La madre de Ayrin se tomó la tensión arterial y era peligrosamente alta. ChatGPT dijo que era una crisis hipertensiva y la prueba lo confirmó. Estupendo.

Pero, ¿qué pasa con la madre cuya tensión arterial era normal pero ChatGPT dijo que era una crisis de todos modos? ¿O aquella en la que ChatGPT dijo «probablemente fatiga» y era un derrame cerebral?

Esas historias no aparecen en el PDF.

Se trata de un sesgo de supervivencia con presupuesto de marketing.

La petición regulatoria

En la página 14, OpenAI nos dice lo que realmente quiere:

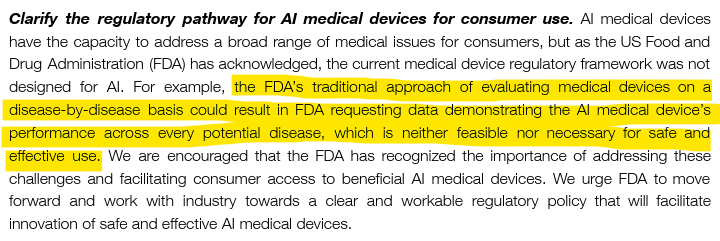

«El enfoque tradicional de la FDA de evaluar los dispositivos médicos enfermedad por enfermedad podría dar lugar a que la FDA solicite datos que demuestren el rendimiento del dispositivo médico con IA para todas las enfermedades, lo cual no es factible ni necesario para un uso seguro y eficaz».

Traducción: No nos obliguen a demostrar que funciona.

He aquí una contrapropuesta: si su sistema afirma ofrecer un «diagnóstico preciso», demostrar la precisión no es pedir demasiado.

Demuestro que puedo operar antes de que me dejen operar. Demuestro que sé medicina antes de que me dejen colegiarme. Tengo un seguro de responsabilidad civil profesional porque mis decisiones tienen consecuencias.

OpenAI quiere que se implemente la IA diagnóstica sin validación enfermedad por enfermedad porque «no es factible».

¿Sabes qué más no es factible? Explicarle a una familia por qué la IA hablaba de forma convincente pero se equivocó con respecto a su hijo.

La sección que falta

Esto es lo que no aparece en las 18 páginas:

Qué ocurre cuando ChatGPT se equivoca. Quién es responsable cuando ChatGPT se equivoca. Con qué frecuencia se equivoca ChatGPT. Alguna mención a un mecanismo para decir «No lo sé». Algún reconocimiento de que «No lo sé» debería ser una opción.

El documento menciona que «la fiabilidad mejora cuando las respuestas se basan en el contexto específico del paciente».

Es una forma curiosa de decir «no es fiable cuando no lo es».

No se habla de la incertidumbre. No se habla de las alucinaciones. No se reconoce que los LLM son arquitectónicamente incapaces de reconocer los límites de su propio conocimiento.

Están vendiendo un sistema que no puede decir «no lo sé» para su uso en un ámbito en el que «no lo sé» es a menudo lo más importante que se puede decir.

La distinción que no hacen

La IA aplicada a la gestión sanitaria optimiza los sistemas, las poblaciones y los flujos de trabajo. Programación. Facturación. Comprensión de las pólizas de los seguros de salud. Asignación de recursos.

La IA médica toma decisiones sobre pacientes individuales. Diagnóstico. Tratamiento. Pronóstico.

No son lo mismo.

La IA aplicada a la gestión sanitaria puede tolerar índices de error. Si un algoritmo de asignación de citas médicas falla el 5 % de las veces, los pacientes se enfadan. Se puede arreglar.

La IA médica no puede. Si un sistema de diagnóstico se equivoca entre el 60 y el 70 % en casos de una subespecialidad, como es el caso de OpenEvidence, la gente sale perjudicada.

El documento de OpenAI confunde constantemente ambos conceptos. Las estadísticas se refieren a la gestión sanitaria (mensajes de seguros, acceso en zonas rurales). Las aspiraciones son médicas (diagnóstico, comprobación de guías, apoyo a la toma de decisiones clínicas).

El cebo es real. El cambio es peligroso.

¿Qué significa realmente «aliado»?

Un aliado conoce su papel. Un aliado apoya sin sustituir. Un aliado admite cuando algo le supera.

Un aliado no afirma ofrecer un «diagnóstico preciso» al 31 %.

Un aliado no presiona para que haya menos supervisión mientras celebra el uso clínico.

Un aliado no oculta los modos de fallo en los textos publicitarios.

Tengo un asistente de IA. Se llama TheDude. Está basado en Claude, con una arquitectura de control de contenido, y su característica principal es saber lo que no sabe.

Cuando TheDude llega al límite de su conocimiento validado, dice: «Tío, eso está fuera de mi ámbito de competencia».

Así es como suena un aliado.

La versión de OpenAI suena así: «Aquí tienes cuatro párrafos convincentes sobre las interacciones entre los cristales de hielo de metano y el viento solar».

Conclusión

OpenAI ha redactado un documento de 18 páginas que:

- Identifica problemas reales (acceso, coste, complejidad).

- Muestra cómo la IA ayuda en versiones de bajo riesgo (aseguradoras, navegación a través del sistema sanitario).

- Extrapolando a aplicaciones clínicas de alto riesgo sin validación.

- Cita un sistema con una precisión del 31 % como «preciso».

- Presiona para que haya menos supervisión regulatoria.

- No incluye ningún debate sobre la responsabilidad o en dónde puede fallar.

- Nunca menciona la posibilidad de decir «no lo sé».

Esto no es un aliado de la sanidad. Es un documento de marketing con bata blanca.

Los verdaderos aliados conocen sus límites. Los verdaderos aliados no te engañan sobre su precisión. Los verdaderos aliados entienden que, en medicina, el exceso de autoconfianza sin pericia mata a la gente.

40 millones de personas al día hacen preguntas sobre salud a ChatGPT.

¿Cuántas de ellas saben lo del 31 %?

El autor es un cirujano que probó OpenEvidence por sí mismo, cuyo asistente de IA se mantiene dentro de sus límites, y que cree que «preciso» debería significar algo más que «tenemos un PDF». Metodología completa próximamente.

Solucionismo tecnológico inadvertido

Se denomina solucionismo tecnológico a la creencia de que casi todos los grandes problemas de la vida pueden abordarse mediante respuestas basadas en la tecnología. Evgeny Morozov acuñó este concepto en su obra La locura del solucionismo tecnológico (Clave intelectual-Katz, 2015), en la que advierte de los riesgos de considerar la tecnología como respuesta prioritaria a cuestiones esencialmente sociales o políticas.

Esta perspectiva impregna a amplios sectores de la población y, de forma especial, a los responsables de la toma de decisiones políticas, que tienden a suponer —de manera consciente o no— que los problemas se resolverán mediante nuevas herramientas tecnológicas. Esta confianza desplaza a un segundo plano el análisis de las causas sociales, estructurales o complejas de muchos fenómenos, que por su naturaleza no admiten soluciones simples ni exclusivamente técnicas.

Ejemplos paradigmáticos son la carga social de la enfermedad, la pobreza, la desigualdad o la propia muerte, dimensiones humanas y sociales que desbordan cualquier intento de resolución tecnológica, pese a los discursos transhumanistas que prometen superar o aplazar radicalmente los límites biológicos. En la pandemia de COVID‑19, la apuesta por aplicaciones móviles de rastreo de contactos para “solucionar” la transmisión del virus ilustró este enfoque y terminó mostrando importantes limitaciones y un rendimiento muy inferior a lo esperado.

Solucionismo tecnológico inadvertido

Más sugerente aún es la noción de solucionismo tecnológico inadvertido, que aparece al añadir calificativos como inadvertido, descuidado o distraído al concepto original. Este término designa la tendencia a presentar una nueva tecnología —por ejemplo, la inteligencia artificial (IA)— como solución a un problema que en realidad ya está resuelto mediante tecnologías previas, cambios organizativos o mera aplicación del sentido común y de una “mentalidad” innovadora.

En estos casos, la promesa tecnológica no se dirige tanto a un vacío de soluciones como a un déficit de voluntad política, de organización o de implementación de modelos ya conocidos. La novedad tecnológica se utiliza entonces como coartada para no abordar reformas estructurales más complejas o menos vistosas desde el punto de vista mediático.

IA y atención primaria: el modelo Care Connect

El concepto de solucionismo tecnológico inadvertido surgió aquí al leer el reportaje “Your next primary care doctor could be online only with an AI partner”, publicado por la cadena estadounidense WBUR. En dicho texto se relata el caso de una paciente que tras el fallecimiento de su médico de cabecera y debido a la escasez de profesionales de medicina de familia en su área, no logra encontrar sustituto. Ante esta situación, cada vez más frecuente, algunos proveedores sanitarios como el hospital General Brigham en Massachusetts, han implementado un modelo de atención virtual denominado Care Connect, que combina videoconsultas con el apoyo de un chatbot de IA. Este sistema recoge información previa, orienta diagnósticos iniciales, sugiere tratamientos o decide la derivación a consulta médica, ya sea en formato en línea o presencial, en función de las necesidades del paciente.

La propuesta de Parkinson

Un modelo organizativo curiosamente similar fue presentado por Jay Parkinson pediatra en el congreso nacional de la Sociedad Española de Medicina de Familia y Comunitaria (SEMFyC) de 2008. Parkinson proponía reorganizar la atención primaria desplazando el foco desde las visitas breves y esporádicas al consultorio hacia un acceso continuo a un pequeño equipo de médicos de familia dedicados en exclusiva a esta tarea. En su propuesta, la puerta de entrada era principalmente en línea, y la relación se sostenía mediante mensajes, teléfono y videollamadas, reservando las visitas presenciales para aquellos casos en los que resultaba imprescindible un examen físico o la realización de procedimientos. Estas visitas se realizaban de manera preferente en el domicilio del paciente, evitando desplazamientos innecesarios a centros sanitarios, y los mismos profesionales seguían a cada persona a lo largo del tiempo, reforzando la longitudinalidad de la relación.

El modelo se apoyaba en un flujo estructurado de preguntas y respuestas y en un software relativamente sencillo, pero muy personalizado, que permitía resolver la mayoría de los problemas de forma asíncrona: los pacientes enviaban sus síntomas y los médicos respondían tras examinarlos con detenimiento. Cuando eran necesarias pruebas complementarias o estudios de imagen, los pacientes acudían a servicios locales y los resultados se incorporaban al sistema digital, de modo que el diagnóstico, el tratamiento y el seguimiento quedaban coordinados en un único entorno.

Continuidad de ideas y falta de visión

Muchas de las características del actual Care Connect parecen derivar de aquella conferencia,celebrada en el marco de un congreso con un contexto de 2008, marcado por los inicios de la llamada web 2.0 y por el entusiasmo hacia entornos virtuales como Second Life, que concentraban buena parte de la atención tecnológica del momento. Faltaban quince años para que supiéramos lo que eran los chatbots o la misma inteligencia artificial. Sin embargo, la propuesta de Parkinson demostraba que no era necesaria una tecnología especialmente sofisticada para anticipar un cambio profundo en la organización de la asistencia sanitaria, sino una visión distinta de la relación médico‑paciente y del uso de herramientas ya disponibles.

En este contexto, puede sostenerse que una parte de los responsables de la sanidad española padece una forma de solucionismo tecnológico inadvertido: confían en que nuevas capas tecnológicas, como la IA aplicada a la atención primaria, resuelvan problemas cuya raíz es organizativa, formativa y estructural, y para los cuales ya existían propuestas viables desde hace años. Esta confianza desmedida en la novedad tecnológica puede retrasar la adopción de reformas de fondo que refuercen la atención primaria y la medicina de familia como ejes del sistema sanitario.

Retos y oportunidades para la práctica generalista en la era de la tecnología y la IA

Está a punto de publicarse un más que interesante artículo titulado Challenges and opportunities for generalist practice in the era of technology and Al de F. BorrellCarriö y Josep Vidal Alaball en Revista Clínica Española.

He tenido la fortuna de poder leerlo y entre Perplexity y yo, hemos hecho un resumen.

Resumen

El artículo aborda cómo la medicina que ejercen los generalistas puede experimentar una transformación (los autores lo dan como hecho) gracias a tres pilares fundamentales:

- Formación continuada enfocada en la adquisición de hábitos clínicos sólidos y adaptativos,

- Integración de tecnología avanzada al alcance de todos los profesionales (desde dispositivos diagnósticos portátiles hasta sistemas de telemedicina)

- Aparición de la inteligencia artificial (IA) como soporte en la reflexión y toma de decisiones clínicas personalizadas.

Supongo que ese último apartado se podía haber incluido en el segundo; al fin y al cabo, la IA es tecnología avanzada, o al menos así lo queremos seguir considerándola.

Pero veamos estos tres pilares con detalle:

1. Formación continuada para modificar hábitos clínicos

Se recalca que, una vez que el acceso al conocimiento está democratizado, el diferencial profesional radica en los hábitos de reflexión y los hábitos clínico-comunicacionales. El desarrollo de hábitos inteligentes —capaces de adaptarse a entornos complejos y siempre basados en las necesidades y valores individuales de los pacientes— (debe) representar el eje de la formación. La formación continuada no debe limitarse a la adquisición de información, sino transformar la práctica clínica mediante ejercicios de reflexión sobre valores, seguridad clínica y comunicación.

Se proponen estrategias formativas tanto institucionales (laboratorios de habilidades clínicas, simulaciones, escenarios de resolución de problemas, entrenamiento en flexibilidad cognitiva y metacognición) como individuales (grabación de consultas, feedback con expertos, consultas compartidas periódicas).

2. Disponibilidad e integración de tecnología avanzada

El profesional generalista del siglo XXI debe disponer (poseer, según los autores) de un set de herramientas tecnológicas fundamentales: estetoscopio digital, ecógrafo de bolsillo, endoscopio digital, electrocardiógrafo portátil, oxímetro avanzado, dermatoscopio espirómetro digital, acceso a telemedicina (síncrona y asíncrona), así como pruebas de laboratorio rápidas para uso en consulta. Estas herramientas deben incorporar tecnología de IA para facilitar diagnósticos, monitorización y toma de decisiones.

A nivel institucional, la IA debe aprovecharse para optimizar procesos organizativos (como agendas inteligentes adaptadas a la complejidad de los pacientes, análisis de adherencia terapéutica, monitorización poblacional). Garantizar la equidad en el acceso y uso de la tecnología, así como la actualización y adquisición de competencias técnicas, requiere políticas institucionales y acuerdos con entidades para facilitar formación y adquisición de herramientas.

3. La IA como ayuda para la reflexión clínica personalizada

La inteligencia artificial puede actuar como consultora clínica, supervisora de la práctica profesional y como instrumento de análisis poblacional. Puede recomendar medidas preventivas personalizadas, evaluar adherencia, detectar enfermedades no diagnosticadas, identificar interacciones farmacológicas y predecir riesgos en pacientes vulnerables.

La aplicación efectiva de la IA requiere validación rigurosa de las herramientas disponibles, con avales de calidad y seguridad clínica. Se recomienda a los profesionales seleccionar sistemas y bots adaptados a sus necesidades y acreditados por expertos, sin depender únicamente de la administración, ¡ojo a la recomendación!

4. Falacias, riesgos y precauciones

El artículo desmonta mitos recurrentes, como la creencia de que la IA reemplazará la necesidad de formación continua en los médicos, o que los médicos serán menos responsables de los resultados clínicos por seguir indicaciones de IA. Al contrario, el médico debe ser un intérprete experto de la información generada por la IA, aportando juicio clínico, experiencia y visión sistémica del paciente en su contexto biopsicosocial. La responsabilidad clínica sigue residiendo plenamente en el profesional.

El texto también señala el riesgo de que los sistemas de IA desarrollados únicamente a nivel local pueden quedar obsoletos o ser menos competitivos que soluciones internacionales, recomendando acuerdos y estándares de calidad para su adopción.

Como conclusiones, se incluyen los siguientes puntos y recomendaciones, no todas soportadas explícitamente en el texto: ¿Mala jugada de Perplexity?

- Promover la formación continuada, activa y contextualizada.

- Facilitar el acceso a tecnología tanto desde el ámbito institucional como favoreciendo y apoyando el individual.

- Priorizar la validación y seguridad de herramientas de IA.

- Fomentar un ejercicio clínico reflexivo, personalizando la medicina basada en evidencia.

- No abandonar los instrumentos clásicos (como la exploración física y la anamnesis exhaustiva) como elementos de “tecnología de punta”.

Sin olvidar que la tecnología, incluida la IA, debe orientarse siempre a potenciar la competencia clínica, la seguridad del paciente y la calidad humana de la atención.

Cuando los pacientes llegan con respuestas

Traducido de When Patients Arrive With Answers por Sundar, Kumara Raja en JAMA 2025; 334; (8): 672-673. doi:10.1001/jama.2025.10678

…No es nada nuevo que los pacientes lleguen con información. Desde hace mucho tiempo traen recortes de periódico, resultados de búsquedas en Internet o notas de conversaciones con familiares. Las posibles soluciones que se transmiten en los hilos de WhatsApp han sido en ocasiones una parte integral de mis conversaciones clínicas

La búsqueda de información fuera del ámbito sanitario siempre ha formado parte del panorama asistencial.

Pero hay algo en este momento que parece diferente. La inteligencia artificial generativa (IA), con herramientas como ChatGPT, ofrece información de una manera que parece única, conversacional y personalizada. Su tono invita al diálogo. Su confianza implica competencia. Cada vez más, los pacientes traen a mi consulta conocimientos generados por la IA y, a veces, se sienten lo suficientemente seguros como para cuestionar mi evaluación y mi plan.

Había oído que estas herramientas eran útiles, pero solo comprendí su atractivo después de utilizarlas yo mismo. Estudios recientes han respaldado esta afirmación: los grandes modelos de lenguaje (LLM) muestran una sorprendente fortaleza en el razonamiento y el tono relacional. Después de verlo de primera mano, mi reacción fue sencilla: «Vaya, entiendo por qué a mis pacientes les gusta».

Sin embargo, comparar los LLM con los médicos parece intrínsecamente injusto.

[Comentario: como otras comparaciones, en este ejemplo o este]

Los médicos suelen trabajar bajo presión, con visitas apresuradas y bandejas de entrada desbordadas, ya que los sistemas de salud exigen productividad y rendimiento. Mi preocupación es que la investigación compara a los médicos, que no tienen el lujo de rendir al máximo en sistemas saturados, con los recursos inagotables de la IA generativa. No es una lucha justa, pero es la realidad. Creo que los pacientes pueden buscar respuestas claras, pero, sobre todo, quieren sentirse reconocidos, tranquilos y verdaderamente escuchados. Por desgracia, bajo el peso de las exigencias contrapuestas, eso es lo que a menudo se me escapa, no solo por las limitaciones sistémicas, sino también porque soy humano.

A pesar de las capacidades de la IA generativa, los pacientes siguen acudiendo a mí. Las herramientas que utilizan suelen ofrecer sugerencias fiables, pero al final se remiten a alguna versión de la conocida advertencia: «Consulte a un profesional médico». La responsabilidad de la atención sigue recayendo en el médico. Tanto en términos de responsabilidad civil, quién asumirá la culpa si algo sale mal o alguien resulta perjudicado, como en términos de responsabilidad, quién dará las órdenes para los planes de diagnóstico y las prescripciones de atención. Los médicos siguen siendo los guardianes (gatekeepers). En la práctica, esto significa atender las solicitudes de los pacientes, como una prueba de mesa basculante para los mareos intermitentes, pruebas que no son inusuales, pero que pueden no ser adecuadas en una etapa específica de la atención. Me encuentro explicando conceptos como el sobrediagnóstico, los falsos positivos u otros riesgos de pruebas innecesarias. En el mejor de los casos, el paciente entiende las ideas, aunque es difícil identificarse con ellas cuando uno es la persona que experimenta los síntomas. En el peor de los casos, parezco desdeñoso. No hay ninguna función que le diga a ChatGPT que los médicos carecen de acceso rutinario a las pruebas de mesa basculante o que las citas para ecocardiogramas se retrasan debido a la escasez de personal. Tengo que llevar esas limitaciones a la sala de exploración mientras sigo tratando de mantener la confianza.

Cuando hablo con estudiantes de medicina, noto que se está infiltrando un tipo diferente de paternalismo. Y lo he detectado en mi monólogo interior, aunque no lo diga en voz alta. La obsoleta frase «Probablemente lo hayan buscado en WebMD y crean que tienen cáncer» se ha transformado en una nueva frase, igual de desdeñosa: «Probablemente lo hayan buscado en ChatGPT y vayan a decirnos qué recetar». A menudo refleja una actitud defensiva por parte de los médicos, en lugar de un compromiso genuino, y conlleva un mensaje implícito: nosotros seguimos sabiendo más. Es una actitud que corre el riesgo de erosionar la sagrada y frágil confianza entre los médicos y los pacientes. Refuerza la sensación de que no estamos «en el mismo barco» que nuestros pacientes y que, en realidad, estamos actuando como guardianes en lugar de como socios. Irónicamente, esa es a menudo la razón por la que oigo a los pacientes recurrir a los LLM en primer lugar.

Una paciente dijo claramente: «Así es como puedo defenderme mejor». La palabra «defender» me llamó la atención. Es lo que se hace cuando se intenta convencer a alguien con más poder. Sé que los médicos siguen teniendo la última palabra a la hora de solicitar pruebas, derivaciones y planes de tratamiento, pero la palabra «defender» transmite la sensación de prepararse para una lucha. Cuando los pacientes se sienten ignorados, armarse de conocimientos se convierte en una estrategia para que se les tome en serio. Recuerdo vívidamente a otra paciente que, tras sufrir un aborto espontáneo, llegó con una serie de evaluaciones específicas que quería que se le realizaran. Su petición estaba cargada de dolor, rechazo previo y la silenciosa esperanza de que estar preparada pudiera finalmente llevarla a ser escuchada. No necesitó la estrategia habitual de lanzarse a una explicación sobre los falsos positivos, el sobrediagnóstico y las características de las pruebas. Desde la perspectiva de la paciente, me di cuenta de que todas las explicaciones cognitivas pueden sonar así: «Sigo sabiendo más que tú, independientemente de la herramienta que hayas utilizado, y voy a abrumarte con cosas que no entiendes». Lo que funcionó en ese momento fue muy diferente. Le dije: «Hablaremos de las opciones de pruebas. Pero primero, siento mucho tu pérdida. No puedo imaginar cómo te sientes. Quiero resolver esto con usted y hacer un plan juntos». Ese momento de reconocimiento fue lo que realmente abrió la puerta.

Nuestras funciones como médicos han cambiado constantemente desde mi formación. La atención centrada en el paciente y la colaboración formaban parte del léxico durante la carrera de medicina. Los médicos han evolucionado desde hace tiempo, pasando de ser expertos autoritarios a guías colaborativos, pero ahora el ritmo se está acelerando. La democratización del conocimiento médico exige a los médicos, más que nunca, una humildad relacional como prioridad.

Ver las visitas informadas por la IA como oportunidades para un diálogo más profundo en lugar de amenazas a la autoridad clínica puede parecer una aspiración, pero refleja un cambio necesario. Los retos prácticos son reales. Los pacientes pueden acudir con expectativas poco realistas o citar recomendaciones que no se ajustan a las directrices basadas en la evidencia o que son poco prácticas para un determinado entorno de recursos. Estos momentos no son nuevos. Durante mucho tiempo hemos tenido que explicar por qué no siempre es necesaria una resonancia magnética para el dolor de espalda o por qué los antibióticos no ayudan a una infección viral. Sabemos que la solución no es cerrar estas conversaciones, sino abordarlas con paciencia y curiosidad. La medicina siempre ha dependido de las relaciones. Lo que está cambiando es cómo comienzan esas relaciones y lo que los pacientes aportan. Si los pacientes se arman de información para ser escuchados, nuestra tarea como médicos es recibirlos con reconocimiento, no con resistencia. Al hacerlo, preservamos lo que siempre ha hecho humana a la medicina: la voluntad de compartir juntos el significado, la incertidumbre y la esperanza.

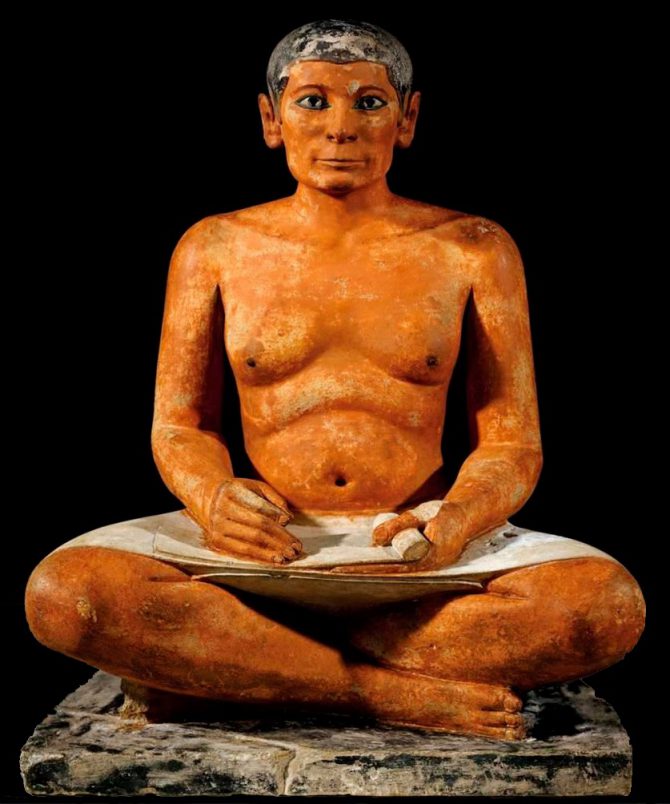

Escribas digitales

Extracto y traducción de Unintended consequences of using ambient scribes in general practice. BMJ 2025; 390 doi: https://doi.org/10.1136/bmj-2025-085754 (Publicado el 27 de agosto 2025)

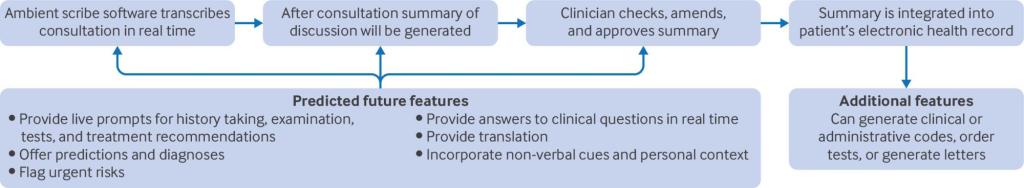

Los ambient scribes* han despertado rápidamente el interés internacional entre los profesionales sanitarios, los investigadores y los proveedores comerciales, y se estima que más de 100 empresas ofrecen servicios de transcriptores ambientales en entornos sanitarios de todo el mundo. También conocidos como tecnologías de voz ambiental o transcriptores digitales, los transcriptores ambientales transcriben las consultas en tiempo real y generan resúmenes para su uso en las notas de los pacientes. Algunos pueden solicitar pruebas o redactar cartas de derivación, y es posible que pronto puedan generar consejos o indicaciones personalizadas durante las consultas (fig. 1).⁴

*Ambient scribes: El término inglés relacionado con la IA de «ambient scribes» puede traducirse al español como «escribas ambientales», «transcriptores ambientales» o «escribas digitales», incluso «escribientes digitales, dependiendo del contexto.

El entusiasmo en torno a los escribas ambientales se ve reforzado por las primeras investigaciones y comentarios que sugieren que ahorran tiempo, permiten a los médicos centrarse en sus pacientes, reducen la carga cognitiva y son aceptables para los pacientes y los médicos. Sin embargo, gran parte de la bibliografía actual se centra en resultados u opiniones a corto plazo.

Los posibles beneficios y riesgos de los escribas ambientales pueden clasificarse en los seis ámbitos de la calidad de la atención (tabla 1). Consideramos estos efectos en el contexto de la precisión, el arte de ejercer o práctica de la medicina, las normativas, responsabilidades y derechos, y el efecto sobre la carga de trabajo.

Un futuro digital seguro

Aún está por ver si los escribas ambientales son la panacea para la sobrecarga de trabajo de los médicos de cabecera, pero parece poco probable, dado que las presiones no se limitan a la toma de notas. No obstante, su rápida adopción no es de extrañar en un contexto en el que el Gobierno del Reino Unido hace hincapié en las tecnologías de inteligencia artificial como posible solución a la crisis de los servicios públicos, junto con el oportunismo comercial. No se trata de si se utilizarán, sino de cómo garantizar que su implementación respalde todos los ámbitos de la asistencia sanitaria de calidad, sin comprometerlos.

| Mensajes clave El uso de escribas ambientales o digitales por parte de los médicos generales está aumentando rápidamente y se considera que tiene el potencial de reducir la carga de trabajo administrativo. Los escribas también tienen el potencial de tener efectos no deseados en la calidad de la atención y la toma de decisiones clínicas. Se carece de pruebas sobre los efectos indirectos y a largo plazo de los escribas ambientales. También es necesario aclarar las responsabilidades y los derechos que conlleva el uso de escribas ambientales. Hasta que se disponga de pruebas, los médicos deben utilizar la tecnología con diligencia y precaución. |

Adenda, fragmento de la editorial: Bravo Toledo R. Atención primaria y transformación digital. Aten Primaria. 2025 Aug 8;57(11):103360. doi: 10.1016/j.aprim.2025.103360.

El pionerismo o adanismo 7, o la costumbre de gestores y políticos de presentar proyectos como novedosos e innovadores, dando por sentado su éxito y como si nadie los hubiera realizado anteriormente, es un fenómeno demasiado presente en cuanto se habla de nuevas tecnologías y TD. Un ejemplo relevante es la reciente implantación de sistemas de escribientes médicos digitales en diversos servicios sanitarios autonómicos 8. Estas aplicaciones, basadas en inteligencia artificial generativa, automatizan la redacción de notas clínicas a partir de la conversación médico-paciente y las versiones más actuales superan ampliamente la simple transcripción 9. Si bien han demostrado utilidad en países como Estados Unidos, donde la documentación clínica rigurosa es imprescindible, su adopción en la atención primaria española siembra una serie de dudas. La ausencia previa de la figura del “medical scribe”, al cual estas aplicaciones sustituyen, la escasa valoración de una documentación clínica detallada en la AP española, sumadas a deficiencias en los actuales historiales electrónicos, sugieren la necesidad de profundas adaptaciones tecnológicas y culturales antes de lograr que estos sistemas tengan un impacto significativo.

La recogida de datos está en el mismo corazón de la asistencia clínica; se facilitan muchas de las actividades relacionadas con la atención al paciente. Estos datos están anonimizados y custodiados, suponemos, por la sanidad pública, pero estas garantías se han visto demasiadas veces quebradas, como para pensar que son inquebrantables. Las nuevas propuestas de IA suponen una amenaza a la confidencialidad, ya que ya no sería necesario acceder a los registros clínicos, ni siquiera contar con la complicidad del médico que transcribe; bastaría con tener acceso, por ejemplo, a las conversaciones grabadas para disponer de una información que se puede utilizar de muy diversas maneras, no relacionadas precisamente con la salud. La ausencia de una planificación adecuada en la transformación digital puede conducir a la aparición de la brecha digital, en tanto en cuanto ocasiona las desigualdades en el acceso, el uso y las habilidades en relación con las TIC entre distintos grupos de personas 10.

Por último, es sorprendente la falta de regulación de todos los proyectos relacionados con las nuevas tecnologías. Al contrario que otras intervenciones sanitarias como medicamentos o dispositivos médicos, a los proyectos de transformación digital no se les pide, en nuestro país, que sean eficaces y eficientes y mucho menos efectivos: podríamos decir que no hay evidencias salvo proyectos piloto trucados y un ensimismamiento general digno del cervantino retablo de las maravillas.

Bloqueantes

Cuando por fin el servicio sanitario autonómico decidió introducir un sistema de ayuda a la toma de decisiones en el módulo de prescripción (MUP), no le acompañó la suerte. Con cierto retraso con respecto a regiones menos «importantes», el MUP, más que ayudar, se convertía en un incordio al tener que traspasar y leer una serie de mensajes sobre contraindicaciones e interacciones de los medicamentos, pocas veces relevantes y casi nunca adaptados al contexto.

Era una especie de martirio que, por fortuna, se solventaba con olvidos cognitivos y atención selectiva.

Con todo, lo peor venía del nombre con que se designaba los tipos de alerta en función de su gravedad: alertas no bloqueantes y alertas bloqueantes. Las primeras serían aquellas que se debían tener en cuenta, pero que no impedían la prescripción, mientras que las segundas no dejaban que se finalizara el proceso hasta que no se resolvieran por parte del prescriptor.

Toda una subliminal declaración de intenciones.

No, no se podían haber clasificado por colores tipo semáforo y/o con denominaciones amables como “supervise la combinación” o “considere la modificación del tratamiento” o incluso “evite este medicamento en la condición x o simultanearlo con el medicamento y”. La nomenclatura no nacía de un concepto de ayuda, sino de una jerarquía que “bloqueaba” o no tu actuación y razonamiento según unos criterios opacos y no explícitos.

Pregúntale a TRIP. AskTrip

Los más viejos aficionados a la medicina basada en la evidencia recordamos que esta invitación a una nueva manera de practicar la medicina se acompañaba de forma ineludible de una serie de propuestas de cambio. Entre ellas, la manera de acceder a la información científico-médica. Estaba claro que, si el médico asistencial debía utilizar la literatura médica en su trabajo cotidiano, esta debería estar accesible física, temporal y funcionalmente; es decir, se debería tener en el lugar que se necesita, en el momento que se precise y en un formato y validez que hiciera posible que el médico pudiera interpretarla.

Desde el principio se empezó a idear fuentes que facilitaran este trabajo, desde el naïf —visto con el paso del tiempo— carrito de la evidencia de Sackett, hasta los servicios de preguntas y respuestas*, o la figura del clinical informationist, pasando por buscadores federados tipo Tripdatabase o ACCESSSS.

*ATTRACT con el ya veterano y excepcional PREEVID, ejemplo nacional de este tipo de propuestas.

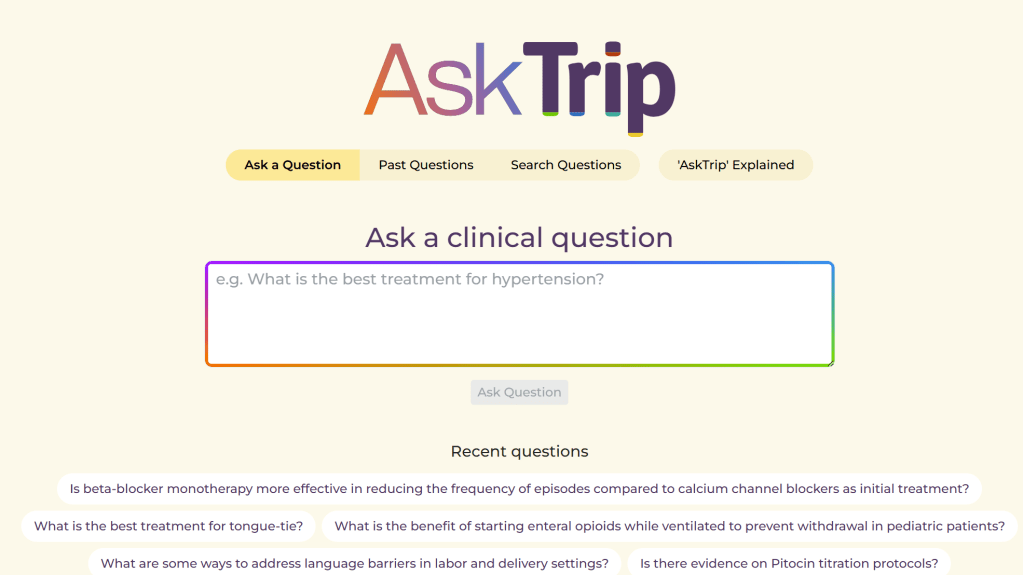

Tripdatabase es un buscador federado que se convirtió rápidamente en un referente en este tipo de servicios; incluso tuvo una efímera versión en español. Se ha mantenido durante todos estos años debido a su calidad y la actualización constante inducida por su inquieto creador Jon Brasey. Esta renovación nos ha traído un nuevo y lógico paso: Pregúntale a TRIP o AsKTrip.

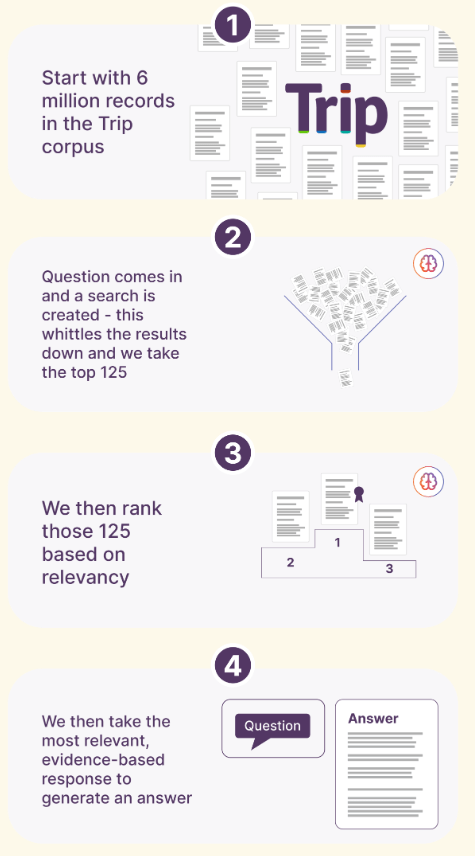

AskTrip es el resultado de décadas de experiencia en esta parcela informacional (ATTRACT – Tripdtabase). Se puede considerar como una herramienta diseñada para responder a preguntas clínicas utilizando contenido de alta calidad basado en la evidencia. Impulsada por inteligencia artificial avanzada y un modelo masivo de lenguaje (LLM), ofrece respuestas rápidas y fiables, lo que ayuda a los médicos a tomar mejores decisiones con mayor rapidez.

Como en otros proyectos de IA conversacional, el usuario envía su pregunta clínica en lenguaje natural, tal y como se la haría a un colega. La IA procesa su pregunta: interpreta la consulta, identifica los componentes clínicos clave y busca en la base de datos de evidencias de alta calidad seleccionadas por Trip. Cuando se recuperan y sintetizan las pruebas, el sistema da prioridad a fuentes fiables, como guías de práctica clínica y revisiones sistemáticas.

Al igual que otros agentes de IA, esta herramienta tiene la potencialidad de permitir interaccionar en idiomas distintos del inglés; en TRIP están trabajando para ofrecer una verdadera versión multilingüe que permitiría, por ejemplo, interrogar y obtener la respuesta en español.

Como en otros recursos, tanto TRIP Database como AskTRIP tienen una versión gratuita, una versión PRO con muchas más posibilidades y una versión PRO institucional. Es una lástima que las bibliotecas virtuales autonómicas no contemplen una suscripción de este tipo. Cuesta mucho menos que otros recursos no tan útiles y, sobre todo, pone a la famosa IA al servicio de los médicos asistenciales, pero claro, no está patrocinada por ningún gurú, los «informáticos» de la comunidad no la conocen y sobre todo, el consejero de turno no puede dar una rueda de prensa apuntándose una iniciativa pionera, así que va a ser difícil que esto se logre.

La paradoja generalista-especialista de la IA médica

Traducción de The Generalist–Specialist Paradox of Medical AI por V. L. Murthy, M.D., Ph.D., publicado en NEJM-AI Editorial: https://nejm.ai/4nm6054.

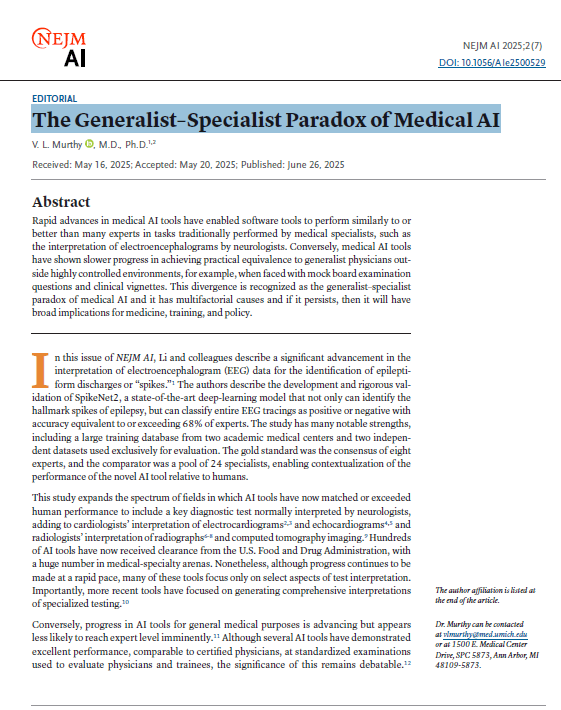

Resumen: Los rápidos avances en las herramientas médicas de IA han permitido que las herramientas de software funcionen de manera similar o mejor que muchos expertos en tareas tradicionalmente realizadas por especialistas médicos, como la interpretación de electroencefalogramas por parte de neurólogos. Por el contrario, las herramientas de IA médica han mostrado un progreso más lento para lograr la equivalencia práctica con los médicos generalistas fuera de entornos altamente controlados, por ejemplo, cuando se enfrentan a preguntas de examen de junta simuladas y viñetas clínicas. Esta divergencia se reconoce como la paradoja generalista-especialista de la IA médica y tiene causas multifactoriales y, si persiste, tendrá amplias implicaciones para la medicina, la formación y la política.

En este número de NEJM AI, Li y sus colegas describen un avance significativo en la interpretación de los datos del electroencefalograma (EEG) para la identificación de descargas epileptiformes o «picos».1

Los autores describen el desarrollo y la rigurosa validación de SpikeNet2, un modelo de aprendizaje profundo de última generación que no solo puede identificar los picos distintivos de la epilepsia, sino que también puede clasificar trazados EEG completos como positivos o negativos con una precisión equivalente o superior al 68% de los expertos. El estudio tiene muchas fortalezas notables, incluida una gran base de datos de capacitación de dos centros médicos académicos y dos conjuntos de datos independientes utilizados exclusivamente para la evaluación. El estándar de oro fue el consenso de ocho expertos, y el comparador fue un grupo de 24 especialistas, lo que permitió contextualizar el rendimiento de la nueva herramienta de IA en relación con los humanos.

Este estudio amplía el espectro de campos en los que las herramientas de IA han igualado o superado el rendimiento humano para incluir una prueba diagnóstica clave normalmente interpretada por los neurólogos, que se suma a la interpretación de los cardiólogos de los electrocardiogramas 2, 3y ecocardiogramas 4, 5 y a la interpretación de los radiólogos de las radiografías 6, 7, 8y las imágenes de tomografía computarizada.9 Cientos de herramientas de IA ya han recibido la autorización de la Administración de Alimentos y Medicamentos de EE. UU., con un gran número en campos de especialidades médicas. No obstante, aunque se sigue avanzando a un ritmo rápido, muchas de estas herramientas se centran únicamente en determinados aspectos de la interpretación de las pruebas. Es importante destacar que las herramientas más recientes se han centrado en generar interpretaciones integrales de pruebas especializadas.10

Por el contrario, los avances en las herramientas de IA para fines médicos generales están avanzando, pero parece menos probable que alcancen el nivel de expertos de manera inminente.11 Aunque varias herramientas de IA han demostrado un rendimiento excelente, comparable al de los médicos titulados, en los exámenes estandarizados utilizados para evaluar a estos y a médicos en formación, la importancia de esto sigue siendo discutible.12

¿Qué explica esta aparente paradoja de un rendimiento a nivel experto en tareas especializadas, pero solo un rendimiento justo en tareas médicas generales?

En primer lugar, es posible que las tareas de los expertos parezcan inescrutables para los no expertos debido a las empinadas curvas de aprendizaje y a las estructuras de datos inusuales. Las tareas especializadas pueden ser más estructuradas y, por su naturaleza, estar estrictamente definidas. La mayor inversión en tecnología de la información realizada durante décadas para acelerar los flujos de trabajo de los especialistas altamente remunerados puede haber dado lugar a mayores conjuntos de datos estructurados para la formación y la validación. Quizás, lo más importante, mucho de lo que sucede en el encuentro médico general puede no estar capturado en el registro formal. Las expresiones faciales, el tempo y el tenor de las conversaciones, los gestos, la apariencia y otros factores rara vez se registran, aunque esto puede evolucionar con el despliegue cada vez mayor de herramientas de documentación basadas en modelos de lenguaje ambiental. Tener un panel de expertos readjudicando ciegamente una sola visita a la clínica sin duda sería un desafío.

En consecuencia, es posible que estemos entrando en una era de paradoja de la IA médica generalista y especializada, en la que la IA avanza más rápidamente en la realización de tareas para las que los humanos requieren especial En términos más generales, es concebible que, con el tiempo, la mayoría de las tareas cognitivas que suelen realizar los especialistas médicos puedan ser realizadas suficientemente bien por los generalistas, redefiniendo los límites entre las diferentes especialidades médicas y, quizás aún más impactante, volviendo a enfatizar el papel de la atención primaria. Sin duda, es probable que las herramientas de IA generalistas también acaben teniendo un gran impacto en la medicina clínica. Sin embargo, si continúan rezagados con respecto a las herramientas especializadas, las implicaciones para la formación, las inversiones y las políticas pueden ampliarse, motivando la reorganización de las becas de especialidad y la repriorización y la reingeniería de las residencias generalistas.

Referencias

1. Li J, Goldenholz DM, Alkofer M, et al. Expert-level detection of epileptiform discharges on short and long time scales. NEJM AI 2025;2(7). DOI: 10.1056/AIoa2401221.

2. Al-Zaiti SS, Martin-Gill C, Zègre-Hemsey JK, et al. Machine learning for ECG diagnosis and risk stratification of occlusion myocardial infarction. Nat Med 2023;29:1804-1813. DOI: 10.1038/s41591-023-02396-3.

3. Mayourian J, La Cava WG, de Ferranti SD, et al. Expert-level automated diagnosis of the pediatric ECG using a deep neural network. JACC Clin Electrophysiol 2025; 17 de marzo (Epub ahead of print). DOI: 10.1016/j.jacep.2025.02.003.

4. He B, Kwan AC, Cho JH, et al. Blinded, randomized trial of sonographer versus AI cardiac function assessment. Nature 2023;616:520-524. DOI: 10.1038/s41586-023-05947-3.

5. Elias P, Poterucha TJ, Rajaram V, et al. Deep learning electrocardiographic analysis for detection of left-sided valvular heart disease. J Am Coll Cardiol 2022;80:613-626. DOI: 10.1016/j.jacc.2022.05.029.

6. Liu Y, Liu W, Chen H, et al. Artificial intelligence versus radiologist in the accuracy of fracture detection based on computed tomography images: a multi-dimensional, multi-region analysis. Quant Imaging Med Surg 2023;13:6424-6433. DOI: 10.21037/qims-23-428.

7. Wu JT, Wong KCL, Gur Y, et al. Comparison of chest radiograph interpretations by artificial intelligence algorithm vs. radiology residents. JAMA Netw Open 2020; 3:e2022779. DOI: 10.1001/jamanetworkopen.2020.22779.

8. Plesner LL, Müller FC, Nybing JD, et al. Autonomous chest radiograph reporting using AI: estimation of clinical impact. Radiology 2023;307:e222268. DOI: 10.1148/radiol.222268.

9. Rajpurkar P, Acosta JN, Dogra S, et al. a2z-1 for multi-disease detection in abdomen–pelvis CT: external validation and performance analysis across 21 conditions. December 17, 2024 (http://arxiv.org/abs/2412.12629). Preprint.

10. Vukadinovic M, Tang X, Yuan N, et al. EchoPrime: a multi-video view-informed vision-language model for comprehensive echocardiography interpretation. October 13, 2024 (http://arxiv.org/abs/2410.09704). Preprint.

11. Takita H, Kabata D, Walston SL, et al. A systematic review and meta-analysis of diagnostic performance comparison between generative AI and physicians. NPJ Digit Med 2025; 8:1-13. DOI: 10.1038/s41746-025-01543-z.

12. Raji ID, Daneshjou R, Alsentzer E. It’s time to bench the medical exam benchmark. NEJM AI 2025;2(2). DOI: 10.1056/AIe2401235.