Categoría: Medicos

Cómo comunicar «los números» médicos

Traducción y adaptación de Zikmund-Fisher BJ, Thorpe A, Fagerlin A. How to Communicate Medical Numbers. JAMA. 2025 Oct 28; 334(16): 1474-1475. doi: 10.1001/jama.2025.13655.

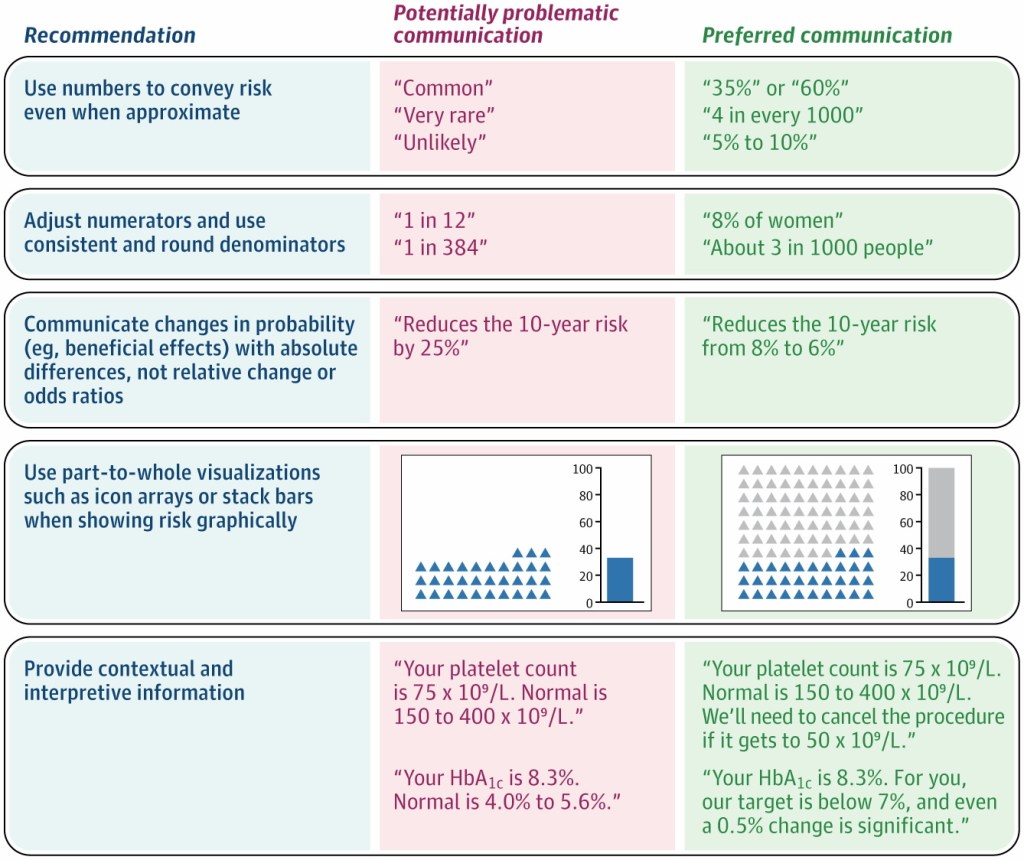

| Conclusions: When communicating health numbers to patients, clinicians can improve patient understanding by presenting information using numbers rather than providing verbal probability terms such as rare, common, or unlikely; using consistent denominators; discussing absolute rather than relative risks; and providing context for unfamiliar types of data. Conclusión: Al comunicar cifras relacionadas con la salud a los pacientes, los médicos pueden mejorar la comprensión de estos presentando la información mediante cifras en lugar de términos verbales que expresan probabilidad, como «raro», «común» o «poco probable»; utilizando denominadores coherentes; analizando los riesgos absolutos en lugar de los relativos; y proporcionando contexto para los tipos de datos con los que no están familiarizados. |

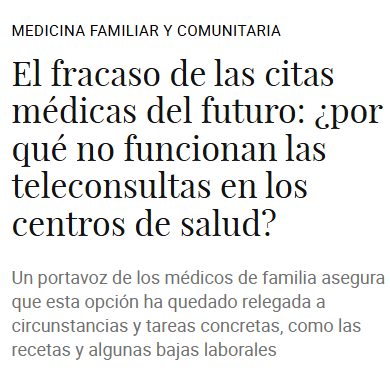

En medicina de familia, la forma en que comunicamos probabilidades y cifras influye directamente en la comprensión del paciente, su adherencia terapéutica y sus decisiones de salud. Este artículo propone cinco recomendaciones basadas en evidencia para mejorar esa comunicación:

- Usa números, no palabras vagas: términos como «raro», «común» o «improbable» se interpretan de forma muy diferente entre pacientes. Por ejemplo, el término «raro» ha sido asociado a probabilidades entre el 0% y el 80% según distintos estudios. Siempre que sea posible, ofrece una cifra concreta, aunque sea aproximada: «Este efecto ocurre en aproximadamente el 2% de los casos» es mucho más útil que «es poco frecuente».

- Usa denominadores constantes: el formato «1 de cada X» confunde a los pacientes y hace que sobreestimen el riesgo. Es preferible usar porcentajes o tasas por 1.000 con denominadores fijos: «8,9 por cada 1.000» se entiende mejor que «1 de cada 112».

- Comunica las diferencias en riesgos absolutos, no relativos: decir que un tratamiento «reduce el riesgo a la mitad» sobreestima su beneficio percibido. Comunicar el riesgo en términos absolutos es más honesto y comprensible: «Este tratamiento reduce tu riesgo del 15% al 7-8%» en lugar de «reduce el riesgo un 50%». Usar distintos formatos para beneficios y riesgos (relativo para uno, absoluto para el otro) como hacen algunas guías clínicas y/o la propaganda de cribados o screening, crea una falsa equivalencia.

- Usa gráficos parte-todo: cuando uses gráficos, muestra tanto el numerador como el denominador. Los graficos parte-todo son tipos de gráficos que muestran cómo componentes individuales contribuyen a un total general. Los diagramas de iconos (icon arrays) y las barras apiladas representan bien esta relación. Los gráficos de barras convencionales solos tienden a exagerar la percepción de riesgo al mostrar solo el numerador.

- Contextualiza los datos de laboratorio y biomarcadores: no basta con decir el valor; hay que interpretarlo. Complementa el resultado con rangos de normalidad, umbrales de acción y diferencias clínicamente relevantes. Por ejemplo: «Tu HbA1c es 8,3%. El objetivo para ti es menos del 7%, y una variación de 0,5% ya es significativa.»

En la consulta

Pequeños cambios, gran impacto

La comunicación de cifras no es un detalle menor: es parte del acto clínico. Adoptar estas estrategias en la consulta de medicina de familia puede marcar la diferencia entre un paciente que comprende su situación y toma decisiones informadas, y uno que sale confundido o sobrestimando riesgos inexistentes.

- Usa números concretos en lugar de palabras vagas.

- Emplea denominadores fijos (% (tasa por 1.000).

- Comunica diferencias en riesgo absoluto.

- Muestra visualizaciones parte-todo cuando uses gráficos.

- Contextualiza siempre los valores analíticos con rangos y objetivos.

Fuente: Zikmund-Fisher BJ, Thorpe A, Fagerlin A. How to Communicate Medical Numbers. JAMA. 2025;334(16):1474-5

Lo que la gente realmente quiere de su médico de cabecera: es más sencillo de lo que crees

Traducido de The Convesation. What people really want from their GP – it’s simpler than you might think por Helen Atherton Professor of Primary Care Research, University of Southampton

Reservar una cita con el médico de cabecera es una tarea rutinaria, pero para muchas personas es motivo de frustración. Las largas esperas, los sistemas confusos y los procesos impersonales se han convertido en algo habitual. Aunque se ha prestado mucha atención a lo difícil que es conseguir una cita, son pocos los estudios que se han planteado una pregunta más fundamental:

¿Qué es lo que realmente quieren los pacientes de su médico de cabecera?

Para responder a esta pregunta, mis colegas y yo revisamos 33 estudios con diferentes diseños, y nos centramos en las expectativas y preferencias de los pacientes con respecto al acceso a su médico de cabecera en Inglaterra y Escocia.

Lo que la gente quería no era complicado ni innovador. La gente buscaba conexión; una recepcionista amable y una buena comunicación por parte de la consulta sobre cómo podían concertar una cita. Y querían un médico de cabecera en su propio barrio, con salas de espera limpias y tranquilas. Hasta aquí, todo muy sencillo.

La gente quería sistemas de cita sencillos y fáciles de usar, sin largos menús telefónicos automatizados («pulse uno para recepción»). Las preferencias variaban. Algunos pacientes valoraban la opción de pedir citas en persona en la recepción, mientras que otros preferían la comodidad de pedirla online.

Independientemente de cómo lo pidieran, los pacientes querían tiempos de espera más cortos o, al menos, información clara sobre cuándo podían esperar una cita o una llamada.

Lo ideal sería que la consulta de medicina general estuviera abierta los sábados y domingos para aquellos que no pueden acudir durante la semana.

Las consultas a distancia, por teléfono, vídeo o correo electrónico, se han vuelto más comunes desde la pandemia, y muchos pacientes las encontraron útiles. Para aquellos con responsabilidades de cuidado o problemas de movilidad, ofrecían una forma conveniente de acceder a la atención médica sin necesidad de salir de casa.

Sin embargo, las consultas a distancia no eran adecuadas para todos. Algunos pacientes carecían de privacidad en el trabajo, mientras que otros, en particular aquellos con discapacidades auditivas, encontraban las consultas telefónicas difíciles o imposibles de utilizar.

Lo que los pacientes querían de manera sistemática era poder elegir, especialmente en lo que se refiere a las consultas a distancia. Aunque las citas presenciales se consideraban el estándar de referencia, muchos reconocían que las consultas telefónicas o por vídeo podían ser útiles en determinadas situaciones. Las preferencias variaban mucho, lo que hacía que la posibilidad de elegir el tipo de consulta fuera especialmente importante.

Los pacientes también querían poder elegir a quién acudir, especialmente para cuestiones no urgentes o para el tratamiento de enfermedades crónicas. En la medicina general actual, la atención suele ser prestada por una serie de profesionales, entre los que se incluyen enfermeros, farmacéuticos y fisioterapeutas. Aunque muchos pacientes se mostraban abiertos a acudir a diferentes profesionales sanitarios, las personas mayores y las pertenecientes a minorías étnicas eran más propensas a preferir acudir al médico de cabecera.

En general, los pacientes querían tener la opción de elegir al médico de cabecera en lugar de a otro profesional sanitario, o al menos participar en esa decisión.

Satisfacción en mínimos históricos

Como era de esperar, lo que los pacientes esperan de la medicina general varía en función de sus diferentes estilos de vida, necesidades y circunstancias. Pero lo que también quedó claro es que muchas personas no consiguen lo que quieren del sistema de citas.

Según una reciente encuesta de British Social Attitudes, la satisfacción de los pacientes con la medicina general se encuentra en mínimos históricos, ya que solo algo menos de una de cada tres personas afirma estar muy o bastante satisfecha con los servicios de los médicos de cabecera.

Algunos elementos del plan decenal para el NHS en Inglaterra anunciado recientemente por el Gobierno británico pueden abordar algunas de estas preocupaciones, pero aún no hay nada seguro. El énfasis en la aplicación del NHS como «un médico en el bolsillo» no se ajusta a lo que muchos pacientes piden: una verdadera opción entre acceder a la atención médica en línea o en persona.

Visité una EBA, y pensé: “¡Que esto se mueva!”

por Mar Sacristan Germes .Medico de familia

El pasado 23 enero tuve la oportunidad de visitar durante 4 horas una entidad de base asociativa catalana (EBA), el EAP de Sardenya en Barcelona, de la mano de su director Jaume Sellarès. Había compartido con él y con Araceli Rivera una mesa en el congreso Semfyc dinamizada por Rafa Bravo, con el título “La necesaria reforma de la atención primaria: propuestas desde la heterodoxia”. No es mi intención (ni capacidad) hacer un análisis riguroso, pero recibo con gusto la invitación a compartir impresiones, así en formato conversación imaginada en un café con algún colega de primaria.

¿Por qué fuiste? ¿Te planteas ir a trabajar allí?

No, fui por el interés de conocer otras formas de gestión. Siempre aprovecho los tiempos de formación/rotación para ver otras maneras. Creo que es la mejor forma para tener opinión sobre lo propio y para imaginar alternativas. Además de ser muy divertido.

¿Qué son las EBAs?

Entidades de base asociativa, centros de salud autogestionados dentro de la red pública de atención primaria catalana. El contrato es con la sanidad pública, a donde tienen que rendir cuentas y resultados, pero tienen una gran autonomía de gestión para decidir el cómo. Hay 13 en Cataluña y llevan 25 años de andadura.

¿Cómo era el centro? ¿ Los pacientes saben que su centro es “diferente”?

Tiene un aspecto muy cuidado: “Nos dicen que parecemos un centro privado”. Mucho que envidiar para los centros viejos de Madrid ciudad, menos que envidiar para otros de la periferia que tienen tanta luz y verdor. Tenía una pega importante: la ausencia de ventilación y luz naturales. El letrero de la puerta es como el de cualquier centro. Habrá pacientes que sepan que su centro funciona de forma peculiar, pero muchos otros no se darán cuenta.

¿Cómo es el acceso del paciente?

Nada más entrar hay un recepcionista que orienta al paciente. Si precisa más detalle, le atienden administrativos en unas cabinas abiertas pero diseñadas para favorecer la intimidad, en lugar de un mostrador con mamparas “anticovid” que favorecen el grito.

Si el paciente precisa atención urgente, se gestiona. Pero si precisa atención médica al uso, ¡tachán! se le da una cita telefónica con un asistente clínico. Esta figura es un administrativo con formación específica de más de 6 meses que llamará al paciente desde una oficina tranquila para entender y gestionar su demanda.

¿ Te acuerdas de la época Covid, cuando en la lista leías la demanda de cada paciente? Era maravilloso para gestionar prioridades. Podíamos diferenciar el “dice su hija que la ve desorientada” del “debe dos cajas de ibuprofeno, y quiere en sobres”. Pasada la pandemia, esta experiencia exitosa murió y volvemos a la lista donde no sabemos por qué viene cada cual.

El médico en el EAP Sardenya atiende cada día su consulta, y además gestionará la lista de demandas que le ha filtrado y detallado el asistente clínico, a quien devolverá con anotaciones del tipo “hay que adelantar la colonoscopia, gestiónalo en el hospital”, o “cítamelo esta semana presencial, que venga acompañado”, o “le dejo el volante para laboratorio, cítalos y resultado por teléfono”, o “programa un domicilio”, etc.

Los asistentes clínicos tienen sus cupos de pacientes, de forma que construyen una relación de longitudinalidad. Además, asistente y médico funcionan por parejas, estableciendo sus propios acuerdos. Observaron además cómo la existencia de esta figura redundaba en una mejor atención global a los pacientes. Me recordó al centro de salud de La Chana en Granada, que también tuve oportunidad de visitar, y su gran iniciativa de administrativa de familia fruto del trabajo de Lorenzo Arribas Mir y Juani, y que con arriesgadas adaptaciones de identidades informáticas fuera de protocolo conseguían excelentes resultados y satisfacción.

¿Y el acceso a pruebas complementarias?

El catálogo de pruebas es mayor; el médico de familia puede pedir TAC, RMN… pero más que esto, lo escandaloso es que la demora es nula, ¡te la hacen pasado mañana!

¿ Cómo? ¿ Y no acaban todas las lumbalgias agudas banales solicitando una RMN con tal acceso?

Me dijeron que no, que se hacían siguiendo criterio clínico sin complacencia. Yo imagino que tal accesibilidad condicionará en cierta medida la práctica, como lo hacen tantos otros condicionantes, pero que también se autorregulará por el tamaño grande de los cupos.

¿Qué tamaño tienen los cupos?

2000 pacientes/médico, algo superior a lo habitual en su entorno y en Madrid. Los cupos mayores favorecen contraintuitivamente el abordaje de la complejidad y reducen la atención a la banalidad.

¿Cómo es el resto de la plantilla, el equipo?

La plantilla es similar a lo conocido en casa: medicina, enfermería, pediatras, fisioterapia, trabajo social, odontología… Las enfermeras pasan consulta a su cupo de pacientes, y tienen otras agendas por tareas por decisión propia. Además, hay unidades de investigación y de innovación muy activas.

Sabemos que plantilla y equipo no son lo mismo. En las EBAs las plazas no son por oposición, traslados, movilidades, plazas en propiedad y suplencias, mañanas o tardes. Son grupos de profesionales que se van conformando según necesidad, entrevista y selección dinámica. Las decisiones se toman en junta, donde el voto de los profesionales tiene un peso proporcional a las acciones que tengan en la EBA.

¿Es verdad que las EBAs tienen ánimo de lucro?

Cada profesional tiene opción de comprar acciones que sirven para distribuir el peso en las decisiones. Se venden en cualquier momento o al salir del equipo, por el mismo precio o con un beneficio menor simbólico, sin una clara ganancia.La financiación del centro es pública y proporcional a la población que atiende. Pero también hay otras fuentes de ingresos.

Por ejemplo, cuentan con una unidad de investigación en el centro que, además de concursar proyectos en convocatorias públicas, participa en ensayos cuyo promotor es la industria farmacéutica que paga a través de contratos regulados. (resaltar que los médicos asistenciales no tratan con comerciales de los laboratorios)

En la parte de clínica dental, además de la cartera de servicios habitual se ofrecen otras prestaciones de pago directo, y esto es también una fuente de ingresos extra para el centro, y que se puede reinvertir en prestaciones extra para el global de pacientes.

Podemos resumir que las EBAs se conciben como empresas de economía social, que pueden generar excedente, pero que no se repartirá entre los accionistas, sino que se reinvierte en mejoras para el centro, prestaciones para los pacientes, o proyectos que decida la junta. Asumen riesgo financiero, de forma que también tienen que responder por sus pérdidas, si las tuviera.

Sí es verdad que hay incentivos importantes aparte del salario, ligados a resultados y criterios profesionales. El salario de los médicos de familia tiende a ser mayor que en los centros habituales.

¿Y a ti esto, qué te parece?

Pues es un cambio de paradigma, se me hacía muy raro el lenguaje empresarial. Algunas cosas me generarían incomodidad, como la participación de la industria farmacéutica, aunque sea indirecta. O el hecho de que no se ofrecieran ciertos servicios como seguimiento de anticoagulación o alguna cosa de cirugía menor por no ser reconocidas económicamente por la Conselleria que lo paga al hospital. (Al final no conseguimos ser realmente polivalentes, ¿quizás en algún contexto rural?)

Pero envidiaba mucho esa autonomía de gestión y las decisiones vinculantes de la junta, creo que sentirse parte activa de los procesos genera mayor implicación y afección por lo que se hace.

Al final cada sistema genera sus propios vicios. En nuestra red de gestión pública el pago por estar, con apenas incentivos por diferencias de cupo o estilo de praxis, genera también sus propias perversiones, pérdida de profesionalismo e hipertrofia funcionarial al estilo Ley de Parkinson.

De lo que he conocido hasta ahora, hay un modelo que me recuerda a las EBAs y es el modelo danés de atención primaria, que también tuve oportunidad de visitar, y que ha sido descrito por José Manuel Freire y Juan Gervas como incentivadores de la implicación profesional.

Los médicos generales daneses son autónomos y propietarios de sus consultas, funcionando como empresas privadas bajo contrato con el sistema público. Gestionan sus centros, tienen incentivos económicos ligados a la actividad (capitación y pago por servicio) y están sujetos a estándares de calidad y rendición de cuentas pública. El acceso es universal y gratuito para el paciente, y la financiación predominantemente pública, con contratos regulados. Creo que tan atentos tenemos que estar al ánimo de lucro por incentivos como a la financiación pública de conductas inerciales no resolutivas.

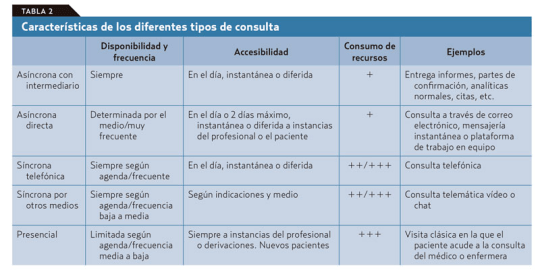

¿Hay datos de los resultados de las EBAs?

Los resultados en salud de parámetros medibles como control FRCV, ingresos evitables, coberturas vacunales, etc son muy similares a la media o ligeramente superiores.

Los datos sobre costes son positivos. Ángel Ruiz Téllez ofrece en su libro “A este lado del espejo” datos muy favorables de sostenibilidad comparada por la mayor resolución de problemas por unidad de coste gestionable (visitas, pruebas, derivaciones, farmacia, IT). Me gustaría saber cuánto se debe al factor autogestión y cuánto se debe al manejo de cupos grandes, pero es difícil el análisis disgregado.

En cuanto a la equidad, leo que las EBAs están sobre todo en zonas de renta media y alta, pero que cuando se han ajustado los resultados por clase social han seguido siendo positivos.

La satisfacción de pacientes y sobre todo profesionales, es más alta. En el EAP de Sardenya se favorece la conciliación, hay un día de teletrabajo y capacidad de organizarse. Además, máxima flexibilidad e importante financiación para formación. Al final lo que se pide es que cada médico responda bien por su cupo: se vigila su profesionalidad, no su agenda.

¿Te vas a una EBA, pues?

No, me quedo en casa. Pero me encantaría que se experimentara algo así en otros muchos contextos. En casa critico proactivamente imposiciones de mi Gerencia como el proyecto piloto de citación con cualquier médico para tratar de resolver lista de espera rompiendo con la longitudinalidad y el sentido de la primaria. Sirva de ejemplo como antípodas de la autogestión, pues la mayoría de médicos implicados estábamos en desacuerdo y nos sentíamos marionetas dirigidas.

Critico las agendas rígidas 30+4 como resultado de la huelga donde el paciente 35 pueda ser el crónico reagudizado que conoces, así como las agendas de rebosamiento donde se citan renovación de receta electrónica.

Propondría la experimentación de nuevas formas de gestión en los centros de nueva creación, que son una oportunidad. Propondría, ante la avalancha de jubilaciones, el ensayo de aumentar los cupos (ajustando por edad, dispersión geográfica y vulnerabilidad social) y trabajar mano a mano con un asistente clínico con longitudinalidad. También que el pago al profesional fuera por salario + capitación. Propondría permitir experimentar, medir para comparar, y si se encuentra algo mejor, cambiar sin miedo.

Mi gran agradecimiento a Jaume por la acogida y a Rafa por el interés compartido.

Webinar Atención Primaria. Soluciones conocidas, ¿por dónde empezar?

Mi participación en el Crisis de la atención primaria: soluciones” desde el centro de salud de AECS emitido el 22 de enero de 2026

Crisis de la atención primaria: “soluciones” desde el centro de salud.

Nuevas oportunidades para nuevos encuentros médico-paciente

Fragmento de Minué Lorenzo S, Bravo Toledo R, Simó Miñana J. Lecciones no aprendidas de la pandemia de la COVID-19. AMF 2020;16(7);384-393.

La atención médica ambulatoria tradicional siempre ha tenido lugar como una conversación oral en tiempo real en una consulta. En la APS de España se añade la particularidad de producirse, en una gran proporción de casos, a instancia del paciente y sin mediar una mínima información previa sobre el motivo de consulta. Esto ha sucedido así de forma invariable durante años, mientras que, en otros lugares, la innovación en la comunicación entre personas avanzaba de forma fulgurante.

Si echamos un vistazo a nuestra forma de relacionarnos con familiares, amigos, compañeros de trabajo, vemos que ha cambiado en muy poco tiempo. Los correos electrónicos y las llamadas telefónicas han sido sustituidos por la mensajería instantánea, redes sociales y herramientas de colaboración. Del ordenador aislado a un elemento conectado que comparte en la nube los documentos y se integra en plataformas corporativas como entorno de trabajo. Estas aplicaciones y, sobre todo, el cambio de costumbre que implica su uso, no se han trasladado a la consulta médica. La consulta sigue anclada en el formato tradicional, con algunos adornos tecnológicos que no aumentan su valor. Resulta patético comprobar cómo las pocas novedades implantadas, como el correo electrónico, se utilizan mal o se prohíbe su uso para intercambiar información con el paciente.

Por otro lado, la pandemia ha mostrado que se puede «pasar consulta» sin prácticamente ver a ningún paciente y que tecnologías tradicionales con un uso marginal previo, como la consulta telefónica, o más avanzadas como la videoconsulta, pueden sustituir, incluso con ventaja, a la consulta presencial. A pesar de las creencias atávicas con respecto a estos tipos de consulta sin contacto, se pueden explorar maneras particulares de relación y continuidad asistencial en los diferentes tipos de encuentros médico-paciente. Pero no se trata de exigir a los profesionales que olviden sus prejuicios y a los sistemas sanitarios públicos una versatilidad y una inversión que no tienen. Tampoco se trata de establecer o añadir nuevas herramientas de comunicación, sino de cambiar radicalmente la forma en la que «vemos a los pacientes».

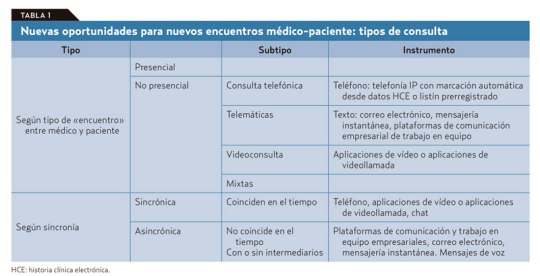

De las tareas diarias que realiza un médico de familia, no todas deben ser irremediablemente presenciales, ni todas se pueden o deben solucionar en una consulta telemática; tampoco todas las consultas requieren que el médico y el paciente estén conectados simultáneamente.

El problema es que de antemano no podemos saber en qué clase va a caer la próxima visita de un paciente que accede libremente y sin ningún tipo de filtro a la agenda del médico. Si se piensa en los diferentes tipos de consulta que podemos ofrecer con este nuevo modelo (tablas 1 y 2): presencial o a distancia por diferentes medios, síncrona o asíncrona; vemos que la que más recursos consume es la síncrona presencial.

Por lo tanto, esta debe ser reservada para los casos en que sea realmente necesaria sin llegar a «okupar» nuestra agenda. Las otras visitas sincrónicas están sujetas, con variaciones, a ineficiencias similares a las que vemos en la visita presencial en el consultorio, salvo que ahorran recursos al paciente y, en ocasiones, tiempo del médico. En cualquier caso, no sería demasiado problema si, como dice Jay Parkinson, hasta el 95% de la interacción médico-paciente puede ejecutarse de manera asíncrona.

Fomentar la consulta asíncrona es una de estas formas de cambio. Las ventajas de la comunicación asincrónica frente a la comunicación síncrona y directa en la consulta son evidentes.

El silenciado éxito de la sanidad pública autogestionada

El domingo 25 de enero, el diario El Punt Avui publicó un extenso artículo de Anna Pinter titulado “L’èxit silenciat de la sanitat pública autogestionada”, sobre las entidades de base asociativa (EBA) que gestionan algunos centros de atención primaria dentro del sistema público catalán. Estas EBAs son empresas de economía social formadas por profesionales sanitarios que gestionan el CAP con gran autonomía, pero financiadas y contratadas por la sanidad pública. El modelo se basa en la autogestión: los propios profesionales organizan recursos, equipos y procesos, con incentivos ligados a resultados de salud, listas de espera, uso adecuado de pruebas y grado de satisfacción. Por último y no menos importante, esta forma de trabajar genera una mayor motivación y menor burnout.

El título de la noticia es bastante elocuente y más si, como hemos hecho en el título de la entrada, cambiamos, sin rubor y con toda la intención, “éxito silencioso” por “silenciado éxito”. Pues sí, sorprende y mucho que, a pesar de que estos especiales centros de salud obtienen buenos resultados de calidad asistencial, satisfacción de los pacientes y eficiencia económica, apenas se habla de ellos en el debate público y menos aún fuera de Cataluña.

No es cuestión de que la idea y estos centros no estén rodados; no es cuestión de tiempo. Estos centros están ahí desde 1993, que se creó el primero, aunque desde 2013 no se ha creado ninguno nuevo. Como expuso Jaume Sellarés en el reciente congreso de la SEMFyC, la autogestión no es una novedad, es una reforma evaluada. En esta ponencia y en el artículo del Punt Avui, se subraya que estos centros suelen tener mejores indicadores que la media del sistema, a menudo con menos burocracia interna y más capacidad de decisión en el día a día.

¿Cuál es el problema, entonces?

¿Por qué una atención primaria sedienta de ideas y de iniciativas organizativas, no adopta estas nuevas formas de gestión?

En la misma Cataluña, la Generalitat no ha extendido el modelo y las EBAs viven en una especie de “limbo” político, con incertidumbre sobre su continuidad futura. Fuera de Cataluña, esta iniciativa se ve con ese paleto recelo nacido de la desconfianza y el desconocimiento. Se une la polémica ideológica: algunos lo critican por introducir fórmulas empresariales en la sanidad pública. Sí, esos que ven la privatización del SNS como una sempiterna amenaza, nunca cumplida, pero que sirve para mantener el decrépito sistema actual. No hay que olvidar tampoco esa ceguera cognitiva que define la célebre frase de Sinclair y que modificada, quedaría así:

«Es difícil hacer que un directivo de atención primaria inicie algo cuando su puesto depende de que no lo inicie.»

En el resto de España navegamos en un contexto de presión asistencial, falta de profesionales y necesidad de innovación organizativa. La experiencia de las EBAs podría aportar muchas lecciones útiles para reforzar la atención primaria pública, antes de su inevitable declive.

En fin, el reportaje es elocuente y suficiente para que el lector se haga la idea de las ventajas de las EBA. Dejamos aquí el enlace a la versión original en catalán, el PDF y el PDF de la traducción al castellano, gracias a Jaume Sellarés.

Telemedicina en AP: ni estuvo, ni está, ni se le espera.

Una de las mentes más lúcidas de la atención primaria española me contó hace tiempo que, tras un cambio en la organización de las consultas en su centro de salud, se encontraron con un resultado inesperado: las salas de espera permanecían vacías la mayor parte del tiempo. Ese vacío, lejos de interpretarse como eficiencia, generaba malestar en algunos pacientes, acostumbrados a salas repletas, que veían la ausencia de gente como un signo de incompetencia o de poco trabajo por parte de los profesionales. Para corregir esa percepción, decidieron entregar, junto con la cita, un número de orden en el que además se indicaba cuántos pacientes habían sido atendidos en cada consulta.

Con frecuencia se leen quejas similares en redes sociales: “Una semana esperando para que me vean y cuando llego, el centro está vacío”. No sorprende esta reacción. Durante la pandemia, una gerente de atención primaria, poco competente, llegó a afirmar que el verdadero trabajo se hacía en los hospitales, porque cuando visitaba los centros de salud veía las salas vacías.

La repuesta es casi comprensible, salvo en el caso de la gerente. Si alguien ha crecido viendo al maquinista echar carbón a la locomotora de un tren de vapor, cuando el tren pasa a ser eléctrico y deja de verlo, tiende a pensar que el maquinista ya no hace nada.

Hace unos días El Confidencial publicó una noticia con un título alarmante ilustrada con la fotografía de una sala de espera vacía y, al fondo, un médico frente al ordenador. El texto sostenía que las “teleconsultas” médicas, presentadas durante la pandemia como el gran salto hacia la medicina del futuro, han terminado ocupando un papel muy limitado en los centros de salud españoles. Según la noticia, estas apenas suponen alrededor de un 15% de la jornada de los médicos de familia y se usan casi siempre para tareas administrativas: renovar recetas, resolver dudas sencillas o gestionar algunas bajas laborales por teléfono.

Se proponen varias explicaciones para esta infrautilización, pero, a mi juicio, el problema no es la tecnología, ni que los pacientes prefieran siempre la consulta presencial, ni que la telemedicina tenga poca capacidad resolutiva, ni siquiera la falta de protocolos o de planificación. Las causas de que la telemedicina no se use, o se use de forma poco adecuada tras el impulso inicial de la pandemia, tienen mucho más que ver con la organización piramidal, jerárquica y poco inteligente de la atención primaria. Con una gerencia sin iniciativa, que por un lado demuestra escasa capacidad organizativa y, por otro, interviene hasta el detalle en las agendas de los médicos, fragmentándolas en tramos de diez minutos. A ello se suma un grupo de profesionales acomodados y temerosos de ofrecer una mayor accesibilidad a los pacientes.

En la noticia se mezclan cosas distintas: la simple llamada telefónica para resolver gestiones puntuales o burocráticas, que muchos centros de salud autoorganizados ya utilizaban, con auténticas consultas telefónicas y videoconsultas. Incluso el representante médico entrevistado añadía al mismo saco las interconsultas entre especialistas y la monitorización a distancia, contribuyendo al batiburrillo conceptual.

La telemedicina, en todas sus variantes, mostró durante la pandemia su enorme potencial tanto asistencial como organizativo, y distintas experiencias aisladas, casi siempre al margen del beneplácito de las gerencias, lo confirmaron. Sin embargo, las instituciones sanitarias no han sabido incorporarla de forma sensata y estable. Han hecho un giro “lampedusiano”: cambiar algunas cosas para que, en el fondo, todo siga igual, sometiendo a la telemedicina a un descrédito del que costará trabajo recuperarse.

Eso sí, las salas de espera han vuelto a llenarse.

OpenAI descubre que la asistencia sanitaria tiene problemas y se ofrece como solución.

Tras la publicación de un documento de OpenAI sobre inteligencia artificial (IA) y asistencia sanitaria. John Ferguson, cirujano americano radicado en Hawaii, hace una lúcida y mordaz crítica del documento en particular y del empeño de las compañías punteras de IA para introducirse en el campo de la asistencia sanitaria. Gracias a Julio Bonis, que nos avisó sobre esta entrada, y al generoso permiso del Dr Ferguson traducimos su entrada original de LinkedIn.

Traduccion de OpenAI Discovers Healthcare Has Problems, Offers to Be the Solution por John Ferguson, MD, FACS President-Elect, ABFCS | Surgeon Solving AI Hallucination in High-Stakes Domains | EdAI CEO | Co-Chair Written Exam Committees |

OpenAI descubre que los servicios de atención sanitaria tienen problemas y se ofrece como solución. o: Cómo citar tu propia precisión del 31% como un «diagnóstico preciso»

OpenAI acaba de publicar un documento de 18 páginas titulado «La IA como aliada de la asistencia sanitaria». Lo he leído para que no tengas que hacerlo. Mi tensión arterial está bien. La he comprobado yo mismo, sin ChatGPT, porque tengo 10 000 millones de neuronas sensoriales y un tensiómetro.

Te lo resumo: los estadounidenses están preocupados por la asistencia sanitaria. La asistencia sanitaria es cara. Los hospitales rurales están cerrando. La gente envía mensajes a ChatGPT sobre seguros de salud. Por lo tanto, la IA debería encargarse del diagnóstico.

Si ese salto lógico te ha dejado atónito, es que estás prestando atención.

El juego de los números

OpenAI quiere que sepas que 40 millones de personas utilizan ChatGPT cada día para preguntas sobre salud. Uno de cada cuatro usuarios pregunta sobre salud cada semana. Casi 600 000 mensajes provienen de reguniones geográficas consideradas «desiertos hospitalarios».

¿Sabes qué tiene también mucho tráfico? WebMD. Las secciones de comentarios de los blogs de madres. Ese tipo de YouTube que cree que se puede curar la diabetes con canela.

El volumen de trafico no equivale a calidad.

Pero aquí es donde se pone interesante. Escondido en la página 10, OpenAI cita OpenEvidence, una plataforma construida usando sus modelos, como apoyo para «diagnósticos precisos verificados a partir de guías de práctica clínica».

OpenEvidence. El sistema de 210 millones de dólares con 400 000 médicos usuarios. 100 % de acierto en los exámenes para una autorización para practicar la medicina (medical licensing exams).

31-41% de acierto en las preguntas que regulan el acceso a las distintas especialidades.

Lo probé yo mismo. Les hice un examen a libro abierto, solo con preguntas en las que tenían acceso directo al material de referencia. Sin asimetría de información. Con todas las ventajas.

Obtuvieron una puntuación inferior al umbral de aprobado.

Próximamente compartiré la metodología y los resultados completos. Pero «preciso» no es la palabra que yo utilizaría para describirlos.

El señuelo y el cambio

El documento realiza un truco de prestidigitación que ya he visto antes:

Paso 1: Establecer un problema real. «Los seguros son confusos. Los hospitales rurales están cerrando. La gente no puede conseguir citas».

Paso 2: Mostrar cómo la IA ayuda con ese problema. «¡ChatGPT ayuda a la gente a entender sus facturas médicas! ¡A entender las condiciones de los seguros! ¡A prepararse para las citas médicas!».

Paso 3: Pasar a un problema completamente diferente. «Y además realiza diagnósticos precisos».

Esto es como decir: «La gente tiene hambre. Los food trucks son populares. Por lo tanto, déjame operarte de apendicitis desde un food truck.

El problema de acceso a la atención sanitaria es real. La IA que ayuda a la gente a descifrar la jerga de los seguros médicos es realmente útil. Pero «explicar la prima y condiciones de tu seguro de salud» y «diagnosticar tu dolor de pecho» no son la misma cosa, tienen el mismo perfil de riesgo ni la misma estructura de responsabilidad.

OpenAI lo sabe. Cuentan con que tú no te des cuenta.

El complejo industrial de las anécdotas

Cada pocas páginas, una historia conmovedora. La madre de Ayrin en Indonesia. La reclamación al seguro de Rich Kaplan. El Dr. Albers en la Montana rural.

¿Sabes qué tienen en común estas historias? La IA tenía razón.

¿Sabes qué falta? Todas las historias en las que no la tenía.

La madre de Ayrin se tomó la tensión arterial y era peligrosamente alta. ChatGPT dijo que era una crisis hipertensiva y la prueba lo confirmó. Estupendo.

Pero, ¿qué pasa con la madre cuya tensión arterial era normal pero ChatGPT dijo que era una crisis de todos modos? ¿O aquella en la que ChatGPT dijo «probablemente fatiga» y era un derrame cerebral?

Esas historias no aparecen en el PDF.

Se trata de un sesgo de supervivencia con presupuesto de marketing.

La petición regulatoria

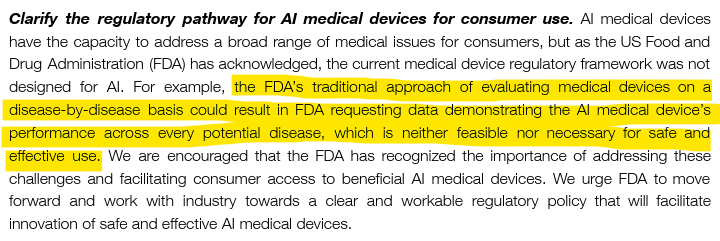

En la página 14, OpenAI nos dice lo que realmente quiere:

«El enfoque tradicional de la FDA de evaluar los dispositivos médicos enfermedad por enfermedad podría dar lugar a que la FDA solicite datos que demuestren el rendimiento del dispositivo médico con IA para todas las enfermedades, lo cual no es factible ni necesario para un uso seguro y eficaz».

Traducción: No nos obliguen a demostrar que funciona.

He aquí una contrapropuesta: si su sistema afirma ofrecer un «diagnóstico preciso», demostrar la precisión no es pedir demasiado.

Demuestro que puedo operar antes de que me dejen operar. Demuestro que sé medicina antes de que me dejen colegiarme. Tengo un seguro de responsabilidad civil profesional porque mis decisiones tienen consecuencias.

OpenAI quiere que se implemente la IA diagnóstica sin validación enfermedad por enfermedad porque «no es factible».

¿Sabes qué más no es factible? Explicarle a una familia por qué la IA hablaba de forma convincente pero se equivocó con respecto a su hijo.

La sección que falta

Esto es lo que no aparece en las 18 páginas:

Qué ocurre cuando ChatGPT se equivoca. Quién es responsable cuando ChatGPT se equivoca. Con qué frecuencia se equivoca ChatGPT. Alguna mención a un mecanismo para decir «No lo sé». Algún reconocimiento de que «No lo sé» debería ser una opción.

El documento menciona que «la fiabilidad mejora cuando las respuestas se basan en el contexto específico del paciente».

Es una forma curiosa de decir «no es fiable cuando no lo es».

No se habla de la incertidumbre. No se habla de las alucinaciones. No se reconoce que los LLM son arquitectónicamente incapaces de reconocer los límites de su propio conocimiento.

Están vendiendo un sistema que no puede decir «no lo sé» para su uso en un ámbito en el que «no lo sé» es a menudo lo más importante que se puede decir.

La distinción que no hacen

La IA aplicada a la gestión sanitaria optimiza los sistemas, las poblaciones y los flujos de trabajo. Programación. Facturación. Comprensión de las pólizas de los seguros de salud. Asignación de recursos.

La IA médica toma decisiones sobre pacientes individuales. Diagnóstico. Tratamiento. Pronóstico.

No son lo mismo.

La IA aplicada a la gestión sanitaria puede tolerar índices de error. Si un algoritmo de asignación de citas médicas falla el 5 % de las veces, los pacientes se enfadan. Se puede arreglar.

La IA médica no puede. Si un sistema de diagnóstico se equivoca entre el 60 y el 70 % en casos de una subespecialidad, como es el caso de OpenEvidence, la gente sale perjudicada.

El documento de OpenAI confunde constantemente ambos conceptos. Las estadísticas se refieren a la gestión sanitaria (mensajes de seguros, acceso en zonas rurales). Las aspiraciones son médicas (diagnóstico, comprobación de guías, apoyo a la toma de decisiones clínicas).

El cebo es real. El cambio es peligroso.

¿Qué significa realmente «aliado»?

Un aliado conoce su papel. Un aliado apoya sin sustituir. Un aliado admite cuando algo le supera.

Un aliado no afirma ofrecer un «diagnóstico preciso» al 31 %.

Un aliado no presiona para que haya menos supervisión mientras celebra el uso clínico.

Un aliado no oculta los modos de fallo en los textos publicitarios.

Tengo un asistente de IA. Se llama TheDude. Está basado en Claude, con una arquitectura de control de contenido, y su característica principal es saber lo que no sabe.

Cuando TheDude llega al límite de su conocimiento validado, dice: «Tío, eso está fuera de mi ámbito de competencia».

Así es como suena un aliado.

La versión de OpenAI suena así: «Aquí tienes cuatro párrafos convincentes sobre las interacciones entre los cristales de hielo de metano y el viento solar».

Conclusión

OpenAI ha redactado un documento de 18 páginas que:

- Identifica problemas reales (acceso, coste, complejidad).

- Muestra cómo la IA ayuda en versiones de bajo riesgo (aseguradoras, navegación a través del sistema sanitario).

- Extrapolando a aplicaciones clínicas de alto riesgo sin validación.

- Cita un sistema con una precisión del 31 % como «preciso».

- Presiona para que haya menos supervisión regulatoria.

- No incluye ningún debate sobre la responsabilidad o en dónde puede fallar.

- Nunca menciona la posibilidad de decir «no lo sé».

Esto no es un aliado de la sanidad. Es un documento de marketing con bata blanca.

Los verdaderos aliados conocen sus límites. Los verdaderos aliados no te engañan sobre su precisión. Los verdaderos aliados entienden que, en medicina, el exceso de autoconfianza sin pericia mata a la gente.

40 millones de personas al día hacen preguntas sobre salud a ChatGPT.

¿Cuántas de ellas saben lo del 31 %?

El autor es un cirujano que probó OpenEvidence por sí mismo, cuyo asistente de IA se mantiene dentro de sus límites, y que cree que «preciso» debería significar algo más que «tenemos un PDF». Metodología completa próximamente.

El país donde florece el limonero

¿Conoces el país en donde florecen los limoneros,

las doradas naranjas brillan entre el follaje oscuro,

un suave viento sopla del cielo azul

y crecen plácido el mirto y alto el laurel?

Johann Wolfgang von Goethe,

Mignon. Kennst du das Land

El país al que hace referencia el poema que da título al texto es Italia. Fue precisamente allí, en Sicilia —y más concretamente en la región conocida como la Concha de Oro, cerca de Palermo— donde, gracias a James Lind, aumentó notablemente la producción de limones.

Este médico inglés realizó el primer ensayo clínico documentado y demostró la eficacia del zumo de limón en el tratamiento del escorbuto. Tras este descubrimiento, la Armada británica —aunque con un considerable retraso, conviene señalarlo— seleccionó a Sicilia como principal proveedor de zumo de limón para la prevención del escorbuto durante las largas travesías marítimas de las tripulaciones de sus barcos.

La isla se convirtió en uno de los principales productores y exportadores de cítricos, generando grandes ganancias para los propietarios y agricultores. Por desgracia, las dificultades de este cultivo, que requería grandes inversiones y esperas, unidas a un contexto de un estado débil y altos índices de pobreza, hicieron que surgieran grupos locales que empezaron ofreciendo protección y terminaron extorsionando y controlando no solo los cultivos, sino también los mercados y las rutas de exportación . Se originó así la Cosa Nostra.

De esta curiosa forma se enlazó a Goethe, con el primer ensayo clínico, las vitaminas de los zumos de los limones y la mafia.

Sigue en AMF: Un vistazo a las últimas publicaciones. El país en donde florecen los limoneros por Rafael Bravo Toledo

Solucionismo tecnológico inadvertido

Se denomina solucionismo tecnológico a la creencia de que casi todos los grandes problemas de la vida pueden abordarse mediante respuestas basadas en la tecnología. Evgeny Morozov acuñó este concepto en su obra La locura del solucionismo tecnológico (Clave intelectual-Katz, 2015), en la que advierte de los riesgos de considerar la tecnología como respuesta prioritaria a cuestiones esencialmente sociales o políticas.

Esta perspectiva impregna a amplios sectores de la población y, de forma especial, a los responsables de la toma de decisiones políticas, que tienden a suponer —de manera consciente o no— que los problemas se resolverán mediante nuevas herramientas tecnológicas. Esta confianza desplaza a un segundo plano el análisis de las causas sociales, estructurales o complejas de muchos fenómenos, que por su naturaleza no admiten soluciones simples ni exclusivamente técnicas.

Ejemplos paradigmáticos son la carga social de la enfermedad, la pobreza, la desigualdad o la propia muerte, dimensiones humanas y sociales que desbordan cualquier intento de resolución tecnológica, pese a los discursos transhumanistas que prometen superar o aplazar radicalmente los límites biológicos. En la pandemia de COVID‑19, la apuesta por aplicaciones móviles de rastreo de contactos para “solucionar” la transmisión del virus ilustró este enfoque y terminó mostrando importantes limitaciones y un rendimiento muy inferior a lo esperado.

Solucionismo tecnológico inadvertido

Más sugerente aún es la noción de solucionismo tecnológico inadvertido, que aparece al añadir calificativos como inadvertido, descuidado o distraído al concepto original. Este término designa la tendencia a presentar una nueva tecnología —por ejemplo, la inteligencia artificial (IA)— como solución a un problema que en realidad ya está resuelto mediante tecnologías previas, cambios organizativos o mera aplicación del sentido común y de una “mentalidad” innovadora.

En estos casos, la promesa tecnológica no se dirige tanto a un vacío de soluciones como a un déficit de voluntad política, de organización o de implementación de modelos ya conocidos. La novedad tecnológica se utiliza entonces como coartada para no abordar reformas estructurales más complejas o menos vistosas desde el punto de vista mediático.

IA y atención primaria: el modelo Care Connect

El concepto de solucionismo tecnológico inadvertido surgió aquí al leer el reportaje “Your next primary care doctor could be online only with an AI partner”, publicado por la cadena estadounidense WBUR. En dicho texto se relata el caso de una paciente que tras el fallecimiento de su médico de cabecera y debido a la escasez de profesionales de medicina de familia en su área, no logra encontrar sustituto. Ante esta situación, cada vez más frecuente, algunos proveedores sanitarios como el hospital General Brigham en Massachusetts, han implementado un modelo de atención virtual denominado Care Connect, que combina videoconsultas con el apoyo de un chatbot de IA. Este sistema recoge información previa, orienta diagnósticos iniciales, sugiere tratamientos o decide la derivación a consulta médica, ya sea en formato en línea o presencial, en función de las necesidades del paciente.

La propuesta de Parkinson

Un modelo organizativo curiosamente similar fue presentado por Jay Parkinson pediatra en el congreso nacional de la Sociedad Española de Medicina de Familia y Comunitaria (SEMFyC) de 2008. Parkinson proponía reorganizar la atención primaria desplazando el foco desde las visitas breves y esporádicas al consultorio hacia un acceso continuo a un pequeño equipo de médicos de familia dedicados en exclusiva a esta tarea. En su propuesta, la puerta de entrada era principalmente en línea, y la relación se sostenía mediante mensajes, teléfono y videollamadas, reservando las visitas presenciales para aquellos casos en los que resultaba imprescindible un examen físico o la realización de procedimientos. Estas visitas se realizaban de manera preferente en el domicilio del paciente, evitando desplazamientos innecesarios a centros sanitarios, y los mismos profesionales seguían a cada persona a lo largo del tiempo, reforzando la longitudinalidad de la relación.

El modelo se apoyaba en un flujo estructurado de preguntas y respuestas y en un software relativamente sencillo, pero muy personalizado, que permitía resolver la mayoría de los problemas de forma asíncrona: los pacientes enviaban sus síntomas y los médicos respondían tras examinarlos con detenimiento. Cuando eran necesarias pruebas complementarias o estudios de imagen, los pacientes acudían a servicios locales y los resultados se incorporaban al sistema digital, de modo que el diagnóstico, el tratamiento y el seguimiento quedaban coordinados en un único entorno.

Continuidad de ideas y falta de visión

Muchas de las características del actual Care Connect parecen derivar de aquella conferencia,celebrada en el marco de un congreso con un contexto de 2008, marcado por los inicios de la llamada web 2.0 y por el entusiasmo hacia entornos virtuales como Second Life, que concentraban buena parte de la atención tecnológica del momento. Faltaban quince años para que supiéramos lo que eran los chatbots o la misma inteligencia artificial. Sin embargo, la propuesta de Parkinson demostraba que no era necesaria una tecnología especialmente sofisticada para anticipar un cambio profundo en la organización de la asistencia sanitaria, sino una visión distinta de la relación médico‑paciente y del uso de herramientas ya disponibles.

En este contexto, puede sostenerse que una parte de los responsables de la sanidad española padece una forma de solucionismo tecnológico inadvertido: confían en que nuevas capas tecnológicas, como la IA aplicada a la atención primaria, resuelvan problemas cuya raíz es organizativa, formativa y estructural, y para los cuales ya existían propuestas viables desde hace años. Esta confianza desmedida en la novedad tecnológica puede retrasar la adopción de reformas de fondo que refuercen la atención primaria y la medicina de familia como ejes del sistema sanitario.