Etiquetado: Inteligencia artificial

OpenAI descubre que la asistencia sanitaria tiene problemas y se ofrece como solución.

Tras la publicación de un documento de OpenAI sobre inteligencia artificial (IA) y asistencia sanitaria. John Ferguson, cirujano americano radicado en Hawaii, hace una lúcida y mordaz crítica del documento en particular y del empeño de las compañías punteras de IA para introducirse en el campo de la asistencia sanitaria. Gracias a Julio Bonis, que nos avisó sobre esta entrada, y al generoso permiso del Dr Ferguson traducimos su entrada original de LinkedIn.

Traduccion de OpenAI Discovers Healthcare Has Problems, Offers to Be the Solution por John Ferguson, MD, FACS President-Elect, ABFCS | Surgeon Solving AI Hallucination in High-Stakes Domains | EdAI CEO | Co-Chair Written Exam Committees |

OpenAI descubre que los servicios de atención sanitaria tienen problemas y se ofrece como solución. o: Cómo citar tu propia precisión del 31% como un «diagnóstico preciso»

OpenAI acaba de publicar un documento de 18 páginas titulado «La IA como aliada de la asistencia sanitaria». Lo he leído para que no tengas que hacerlo. Mi tensión arterial está bien. La he comprobado yo mismo, sin ChatGPT, porque tengo 10 000 millones de neuronas sensoriales y un tensiómetro.

Te lo resumo: los estadounidenses están preocupados por la asistencia sanitaria. La asistencia sanitaria es cara. Los hospitales rurales están cerrando. La gente envía mensajes a ChatGPT sobre seguros de salud. Por lo tanto, la IA debería encargarse del diagnóstico.

Si ese salto lógico te ha dejado atónito, es que estás prestando atención.

El juego de los números

OpenAI quiere que sepas que 40 millones de personas utilizan ChatGPT cada día para preguntas sobre salud. Uno de cada cuatro usuarios pregunta sobre salud cada semana. Casi 600 000 mensajes provienen de reguniones geográficas consideradas «desiertos hospitalarios».

¿Sabes qué tiene también mucho tráfico? WebMD. Las secciones de comentarios de los blogs de madres. Ese tipo de YouTube que cree que se puede curar la diabetes con canela.

El volumen de trafico no equivale a calidad.

Pero aquí es donde se pone interesante. Escondido en la página 10, OpenAI cita OpenEvidence, una plataforma construida usando sus modelos, como apoyo para «diagnósticos precisos verificados a partir de guías de práctica clínica».

OpenEvidence. El sistema de 210 millones de dólares con 400 000 médicos usuarios. 100 % de acierto en los exámenes para una autorización para practicar la medicina (medical licensing exams).

31-41% de acierto en las preguntas que regulan el acceso a las distintas especialidades.

Lo probé yo mismo. Les hice un examen a libro abierto, solo con preguntas en las que tenían acceso directo al material de referencia. Sin asimetría de información. Con todas las ventajas.

Obtuvieron una puntuación inferior al umbral de aprobado.

Próximamente compartiré la metodología y los resultados completos. Pero «preciso» no es la palabra que yo utilizaría para describirlos.

El señuelo y el cambio

El documento realiza un truco de prestidigitación que ya he visto antes:

Paso 1: Establecer un problema real. «Los seguros son confusos. Los hospitales rurales están cerrando. La gente no puede conseguir citas».

Paso 2: Mostrar cómo la IA ayuda con ese problema. «¡ChatGPT ayuda a la gente a entender sus facturas médicas! ¡A entender las condiciones de los seguros! ¡A prepararse para las citas médicas!».

Paso 3: Pasar a un problema completamente diferente. «Y además realiza diagnósticos precisos».

Esto es como decir: «La gente tiene hambre. Los food trucks son populares. Por lo tanto, déjame operarte de apendicitis desde un food truck.

El problema de acceso a la atención sanitaria es real. La IA que ayuda a la gente a descifrar la jerga de los seguros médicos es realmente útil. Pero «explicar la prima y condiciones de tu seguro de salud» y «diagnosticar tu dolor de pecho» no son la misma cosa, tienen el mismo perfil de riesgo ni la misma estructura de responsabilidad.

OpenAI lo sabe. Cuentan con que tú no te des cuenta.

El complejo industrial de las anécdotas

Cada pocas páginas, una historia conmovedora. La madre de Ayrin en Indonesia. La reclamación al seguro de Rich Kaplan. El Dr. Albers en la Montana rural.

¿Sabes qué tienen en común estas historias? La IA tenía razón.

¿Sabes qué falta? Todas las historias en las que no la tenía.

La madre de Ayrin se tomó la tensión arterial y era peligrosamente alta. ChatGPT dijo que era una crisis hipertensiva y la prueba lo confirmó. Estupendo.

Pero, ¿qué pasa con la madre cuya tensión arterial era normal pero ChatGPT dijo que era una crisis de todos modos? ¿O aquella en la que ChatGPT dijo «probablemente fatiga» y era un derrame cerebral?

Esas historias no aparecen en el PDF.

Se trata de un sesgo de supervivencia con presupuesto de marketing.

La petición regulatoria

En la página 14, OpenAI nos dice lo que realmente quiere:

«El enfoque tradicional de la FDA de evaluar los dispositivos médicos enfermedad por enfermedad podría dar lugar a que la FDA solicite datos que demuestren el rendimiento del dispositivo médico con IA para todas las enfermedades, lo cual no es factible ni necesario para un uso seguro y eficaz».

Traducción: No nos obliguen a demostrar que funciona.

He aquí una contrapropuesta: si su sistema afirma ofrecer un «diagnóstico preciso», demostrar la precisión no es pedir demasiado.

Demuestro que puedo operar antes de que me dejen operar. Demuestro que sé medicina antes de que me dejen colegiarme. Tengo un seguro de responsabilidad civil profesional porque mis decisiones tienen consecuencias.

OpenAI quiere que se implemente la IA diagnóstica sin validación enfermedad por enfermedad porque «no es factible».

¿Sabes qué más no es factible? Explicarle a una familia por qué la IA hablaba de forma convincente pero se equivocó con respecto a su hijo.

La sección que falta

Esto es lo que no aparece en las 18 páginas:

Qué ocurre cuando ChatGPT se equivoca. Quién es responsable cuando ChatGPT se equivoca. Con qué frecuencia se equivoca ChatGPT. Alguna mención a un mecanismo para decir «No lo sé». Algún reconocimiento de que «No lo sé» debería ser una opción.

El documento menciona que «la fiabilidad mejora cuando las respuestas se basan en el contexto específico del paciente».

Es una forma curiosa de decir «no es fiable cuando no lo es».

No se habla de la incertidumbre. No se habla de las alucinaciones. No se reconoce que los LLM son arquitectónicamente incapaces de reconocer los límites de su propio conocimiento.

Están vendiendo un sistema que no puede decir «no lo sé» para su uso en un ámbito en el que «no lo sé» es a menudo lo más importante que se puede decir.

La distinción que no hacen

La IA aplicada a la gestión sanitaria optimiza los sistemas, las poblaciones y los flujos de trabajo. Programación. Facturación. Comprensión de las pólizas de los seguros de salud. Asignación de recursos.

La IA médica toma decisiones sobre pacientes individuales. Diagnóstico. Tratamiento. Pronóstico.

No son lo mismo.

La IA aplicada a la gestión sanitaria puede tolerar índices de error. Si un algoritmo de asignación de citas médicas falla el 5 % de las veces, los pacientes se enfadan. Se puede arreglar.

La IA médica no puede. Si un sistema de diagnóstico se equivoca entre el 60 y el 70 % en casos de una subespecialidad, como es el caso de OpenEvidence, la gente sale perjudicada.

El documento de OpenAI confunde constantemente ambos conceptos. Las estadísticas se refieren a la gestión sanitaria (mensajes de seguros, acceso en zonas rurales). Las aspiraciones son médicas (diagnóstico, comprobación de guías, apoyo a la toma de decisiones clínicas).

El cebo es real. El cambio es peligroso.

¿Qué significa realmente «aliado»?

Un aliado conoce su papel. Un aliado apoya sin sustituir. Un aliado admite cuando algo le supera.

Un aliado no afirma ofrecer un «diagnóstico preciso» al 31 %.

Un aliado no presiona para que haya menos supervisión mientras celebra el uso clínico.

Un aliado no oculta los modos de fallo en los textos publicitarios.

Tengo un asistente de IA. Se llama TheDude. Está basado en Claude, con una arquitectura de control de contenido, y su característica principal es saber lo que no sabe.

Cuando TheDude llega al límite de su conocimiento validado, dice: «Tío, eso está fuera de mi ámbito de competencia».

Así es como suena un aliado.

La versión de OpenAI suena así: «Aquí tienes cuatro párrafos convincentes sobre las interacciones entre los cristales de hielo de metano y el viento solar».

Conclusión

OpenAI ha redactado un documento de 18 páginas que:

- Identifica problemas reales (acceso, coste, complejidad).

- Muestra cómo la IA ayuda en versiones de bajo riesgo (aseguradoras, navegación a través del sistema sanitario).

- Extrapolando a aplicaciones clínicas de alto riesgo sin validación.

- Cita un sistema con una precisión del 31 % como «preciso».

- Presiona para que haya menos supervisión regulatoria.

- No incluye ningún debate sobre la responsabilidad o en dónde puede fallar.

- Nunca menciona la posibilidad de decir «no lo sé».

Esto no es un aliado de la sanidad. Es un documento de marketing con bata blanca.

Los verdaderos aliados conocen sus límites. Los verdaderos aliados no te engañan sobre su precisión. Los verdaderos aliados entienden que, en medicina, el exceso de autoconfianza sin pericia mata a la gente.

40 millones de personas al día hacen preguntas sobre salud a ChatGPT.

¿Cuántas de ellas saben lo del 31 %?

El autor es un cirujano que probó OpenEvidence por sí mismo, cuyo asistente de IA se mantiene dentro de sus límites, y que cree que «preciso» debería significar algo más que «tenemos un PDF». Metodología completa próximamente.

Retos y oportunidades para la práctica generalista en la era de la tecnología y la IA

Está a punto de publicarse un más que interesante artículo titulado Challenges and opportunities for generalist practice in the era of technology and Al de F. BorrellCarriö y Josep Vidal Alaball en Revista Clínica Española.

He tenido la fortuna de poder leerlo y entre Perplexity y yo, hemos hecho un resumen.

Resumen

El artículo aborda cómo la medicina que ejercen los generalistas puede experimentar una transformación (los autores lo dan como hecho) gracias a tres pilares fundamentales:

- Formación continuada enfocada en la adquisición de hábitos clínicos sólidos y adaptativos,

- Integración de tecnología avanzada al alcance de todos los profesionales (desde dispositivos diagnósticos portátiles hasta sistemas de telemedicina)

- Aparición de la inteligencia artificial (IA) como soporte en la reflexión y toma de decisiones clínicas personalizadas.

Supongo que ese último apartado se podía haber incluido en el segundo; al fin y al cabo, la IA es tecnología avanzada, o al menos así lo queremos seguir considerándola.

Pero veamos estos tres pilares con detalle:

1. Formación continuada para modificar hábitos clínicos

Se recalca que, una vez que el acceso al conocimiento está democratizado, el diferencial profesional radica en los hábitos de reflexión y los hábitos clínico-comunicacionales. El desarrollo de hábitos inteligentes —capaces de adaptarse a entornos complejos y siempre basados en las necesidades y valores individuales de los pacientes— (debe) representar el eje de la formación. La formación continuada no debe limitarse a la adquisición de información, sino transformar la práctica clínica mediante ejercicios de reflexión sobre valores, seguridad clínica y comunicación.

Se proponen estrategias formativas tanto institucionales (laboratorios de habilidades clínicas, simulaciones, escenarios de resolución de problemas, entrenamiento en flexibilidad cognitiva y metacognición) como individuales (grabación de consultas, feedback con expertos, consultas compartidas periódicas).

2. Disponibilidad e integración de tecnología avanzada

El profesional generalista del siglo XXI debe disponer (poseer, según los autores) de un set de herramientas tecnológicas fundamentales: estetoscopio digital, ecógrafo de bolsillo, endoscopio digital, electrocardiógrafo portátil, oxímetro avanzado, dermatoscopio espirómetro digital, acceso a telemedicina (síncrona y asíncrona), así como pruebas de laboratorio rápidas para uso en consulta. Estas herramientas deben incorporar tecnología de IA para facilitar diagnósticos, monitorización y toma de decisiones.

A nivel institucional, la IA debe aprovecharse para optimizar procesos organizativos (como agendas inteligentes adaptadas a la complejidad de los pacientes, análisis de adherencia terapéutica, monitorización poblacional). Garantizar la equidad en el acceso y uso de la tecnología, así como la actualización y adquisición de competencias técnicas, requiere políticas institucionales y acuerdos con entidades para facilitar formación y adquisición de herramientas.

3. La IA como ayuda para la reflexión clínica personalizada

La inteligencia artificial puede actuar como consultora clínica, supervisora de la práctica profesional y como instrumento de análisis poblacional. Puede recomendar medidas preventivas personalizadas, evaluar adherencia, detectar enfermedades no diagnosticadas, identificar interacciones farmacológicas y predecir riesgos en pacientes vulnerables.

La aplicación efectiva de la IA requiere validación rigurosa de las herramientas disponibles, con avales de calidad y seguridad clínica. Se recomienda a los profesionales seleccionar sistemas y bots adaptados a sus necesidades y acreditados por expertos, sin depender únicamente de la administración, ¡ojo a la recomendación!

4. Falacias, riesgos y precauciones

El artículo desmonta mitos recurrentes, como la creencia de que la IA reemplazará la necesidad de formación continua en los médicos, o que los médicos serán menos responsables de los resultados clínicos por seguir indicaciones de IA. Al contrario, el médico debe ser un intérprete experto de la información generada por la IA, aportando juicio clínico, experiencia y visión sistémica del paciente en su contexto biopsicosocial. La responsabilidad clínica sigue residiendo plenamente en el profesional.

El texto también señala el riesgo de que los sistemas de IA desarrollados únicamente a nivel local pueden quedar obsoletos o ser menos competitivos que soluciones internacionales, recomendando acuerdos y estándares de calidad para su adopción.

Como conclusiones, se incluyen los siguientes puntos y recomendaciones, no todas soportadas explícitamente en el texto: ¿Mala jugada de Perplexity?

- Promover la formación continuada, activa y contextualizada.

- Facilitar el acceso a tecnología tanto desde el ámbito institucional como favoreciendo y apoyando el individual.

- Priorizar la validación y seguridad de herramientas de IA.

- Fomentar un ejercicio clínico reflexivo, personalizando la medicina basada en evidencia.

- No abandonar los instrumentos clásicos (como la exploración física y la anamnesis exhaustiva) como elementos de “tecnología de punta”.

Sin olvidar que la tecnología, incluida la IA, debe orientarse siempre a potenciar la competencia clínica, la seguridad del paciente y la calidad humana de la atención.

Cuando los pacientes llegan con respuestas

Traducido de When Patients Arrive With Answers por Sundar, Kumara Raja en JAMA 2025; 334; (8): 672-673. doi:10.1001/jama.2025.10678

…No es nada nuevo que los pacientes lleguen con información. Desde hace mucho tiempo traen recortes de periódico, resultados de búsquedas en Internet o notas de conversaciones con familiares. Las posibles soluciones que se transmiten en los hilos de WhatsApp han sido en ocasiones una parte integral de mis conversaciones clínicas

La búsqueda de información fuera del ámbito sanitario siempre ha formado parte del panorama asistencial.

Pero hay algo en este momento que parece diferente. La inteligencia artificial generativa (IA), con herramientas como ChatGPT, ofrece información de una manera que parece única, conversacional y personalizada. Su tono invita al diálogo. Su confianza implica competencia. Cada vez más, los pacientes traen a mi consulta conocimientos generados por la IA y, a veces, se sienten lo suficientemente seguros como para cuestionar mi evaluación y mi plan.

Había oído que estas herramientas eran útiles, pero solo comprendí su atractivo después de utilizarlas yo mismo. Estudios recientes han respaldado esta afirmación: los grandes modelos de lenguaje (LLM) muestran una sorprendente fortaleza en el razonamiento y el tono relacional. Después de verlo de primera mano, mi reacción fue sencilla: «Vaya, entiendo por qué a mis pacientes les gusta».

Sin embargo, comparar los LLM con los médicos parece intrínsecamente injusto.

[Comentario: como otras comparaciones, en este ejemplo o este]

Los médicos suelen trabajar bajo presión, con visitas apresuradas y bandejas de entrada desbordadas, ya que los sistemas de salud exigen productividad y rendimiento. Mi preocupación es que la investigación compara a los médicos, que no tienen el lujo de rendir al máximo en sistemas saturados, con los recursos inagotables de la IA generativa. No es una lucha justa, pero es la realidad. Creo que los pacientes pueden buscar respuestas claras, pero, sobre todo, quieren sentirse reconocidos, tranquilos y verdaderamente escuchados. Por desgracia, bajo el peso de las exigencias contrapuestas, eso es lo que a menudo se me escapa, no solo por las limitaciones sistémicas, sino también porque soy humano.

A pesar de las capacidades de la IA generativa, los pacientes siguen acudiendo a mí. Las herramientas que utilizan suelen ofrecer sugerencias fiables, pero al final se remiten a alguna versión de la conocida advertencia: «Consulte a un profesional médico». La responsabilidad de la atención sigue recayendo en el médico. Tanto en términos de responsabilidad civil, quién asumirá la culpa si algo sale mal o alguien resulta perjudicado, como en términos de responsabilidad, quién dará las órdenes para los planes de diagnóstico y las prescripciones de atención. Los médicos siguen siendo los guardianes (gatekeepers). En la práctica, esto significa atender las solicitudes de los pacientes, como una prueba de mesa basculante para los mareos intermitentes, pruebas que no son inusuales, pero que pueden no ser adecuadas en una etapa específica de la atención. Me encuentro explicando conceptos como el sobrediagnóstico, los falsos positivos u otros riesgos de pruebas innecesarias. En el mejor de los casos, el paciente entiende las ideas, aunque es difícil identificarse con ellas cuando uno es la persona que experimenta los síntomas. En el peor de los casos, parezco desdeñoso. No hay ninguna función que le diga a ChatGPT que los médicos carecen de acceso rutinario a las pruebas de mesa basculante o que las citas para ecocardiogramas se retrasan debido a la escasez de personal. Tengo que llevar esas limitaciones a la sala de exploración mientras sigo tratando de mantener la confianza.

Cuando hablo con estudiantes de medicina, noto que se está infiltrando un tipo diferente de paternalismo. Y lo he detectado en mi monólogo interior, aunque no lo diga en voz alta. La obsoleta frase «Probablemente lo hayan buscado en WebMD y crean que tienen cáncer» se ha transformado en una nueva frase, igual de desdeñosa: «Probablemente lo hayan buscado en ChatGPT y vayan a decirnos qué recetar». A menudo refleja una actitud defensiva por parte de los médicos, en lugar de un compromiso genuino, y conlleva un mensaje implícito: nosotros seguimos sabiendo más. Es una actitud que corre el riesgo de erosionar la sagrada y frágil confianza entre los médicos y los pacientes. Refuerza la sensación de que no estamos «en el mismo barco» que nuestros pacientes y que, en realidad, estamos actuando como guardianes en lugar de como socios. Irónicamente, esa es a menudo la razón por la que oigo a los pacientes recurrir a los LLM en primer lugar.

Una paciente dijo claramente: «Así es como puedo defenderme mejor». La palabra «defender» me llamó la atención. Es lo que se hace cuando se intenta convencer a alguien con más poder. Sé que los médicos siguen teniendo la última palabra a la hora de solicitar pruebas, derivaciones y planes de tratamiento, pero la palabra «defender» transmite la sensación de prepararse para una lucha. Cuando los pacientes se sienten ignorados, armarse de conocimientos se convierte en una estrategia para que se les tome en serio. Recuerdo vívidamente a otra paciente que, tras sufrir un aborto espontáneo, llegó con una serie de evaluaciones específicas que quería que se le realizaran. Su petición estaba cargada de dolor, rechazo previo y la silenciosa esperanza de que estar preparada pudiera finalmente llevarla a ser escuchada. No necesitó la estrategia habitual de lanzarse a una explicación sobre los falsos positivos, el sobrediagnóstico y las características de las pruebas. Desde la perspectiva de la paciente, me di cuenta de que todas las explicaciones cognitivas pueden sonar así: «Sigo sabiendo más que tú, independientemente de la herramienta que hayas utilizado, y voy a abrumarte con cosas que no entiendes». Lo que funcionó en ese momento fue muy diferente. Le dije: «Hablaremos de las opciones de pruebas. Pero primero, siento mucho tu pérdida. No puedo imaginar cómo te sientes. Quiero resolver esto con usted y hacer un plan juntos». Ese momento de reconocimiento fue lo que realmente abrió la puerta.

Nuestras funciones como médicos han cambiado constantemente desde mi formación. La atención centrada en el paciente y la colaboración formaban parte del léxico durante la carrera de medicina. Los médicos han evolucionado desde hace tiempo, pasando de ser expertos autoritarios a guías colaborativos, pero ahora el ritmo se está acelerando. La democratización del conocimiento médico exige a los médicos, más que nunca, una humildad relacional como prioridad.

Ver las visitas informadas por la IA como oportunidades para un diálogo más profundo en lugar de amenazas a la autoridad clínica puede parecer una aspiración, pero refleja un cambio necesario. Los retos prácticos son reales. Los pacientes pueden acudir con expectativas poco realistas o citar recomendaciones que no se ajustan a las directrices basadas en la evidencia o que son poco prácticas para un determinado entorno de recursos. Estos momentos no son nuevos. Durante mucho tiempo hemos tenido que explicar por qué no siempre es necesaria una resonancia magnética para el dolor de espalda o por qué los antibióticos no ayudan a una infección viral. Sabemos que la solución no es cerrar estas conversaciones, sino abordarlas con paciencia y curiosidad. La medicina siempre ha dependido de las relaciones. Lo que está cambiando es cómo comienzan esas relaciones y lo que los pacientes aportan. Si los pacientes se arman de información para ser escuchados, nuestra tarea como médicos es recibirlos con reconocimiento, no con resistencia. Al hacerlo, preservamos lo que siempre ha hecho humana a la medicina: la voluntad de compartir juntos el significado, la incertidumbre y la esperanza.

Escribas digitales

Extracto y traducción de Unintended consequences of using ambient scribes in general practice. BMJ 2025; 390 doi: https://doi.org/10.1136/bmj-2025-085754 (Publicado el 27 de agosto 2025)

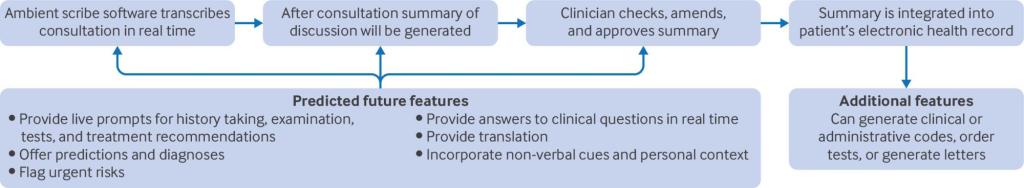

Los ambient scribes* han despertado rápidamente el interés internacional entre los profesionales sanitarios, los investigadores y los proveedores comerciales, y se estima que más de 100 empresas ofrecen servicios de transcriptores ambientales en entornos sanitarios de todo el mundo. También conocidos como tecnologías de voz ambiental o transcriptores digitales, los transcriptores ambientales transcriben las consultas en tiempo real y generan resúmenes para su uso en las notas de los pacientes. Algunos pueden solicitar pruebas o redactar cartas de derivación, y es posible que pronto puedan generar consejos o indicaciones personalizadas durante las consultas (fig. 1).⁴

*Ambient scribes: El término inglés relacionado con la IA de «ambient scribes» puede traducirse al español como «escribas ambientales», «transcriptores ambientales» o «escribas digitales», incluso «escribientes digitales, dependiendo del contexto.

El entusiasmo en torno a los escribas ambientales se ve reforzado por las primeras investigaciones y comentarios que sugieren que ahorran tiempo, permiten a los médicos centrarse en sus pacientes, reducen la carga cognitiva y son aceptables para los pacientes y los médicos. Sin embargo, gran parte de la bibliografía actual se centra en resultados u opiniones a corto plazo.

Los posibles beneficios y riesgos de los escribas ambientales pueden clasificarse en los seis ámbitos de la calidad de la atención (tabla 1). Consideramos estos efectos en el contexto de la precisión, el arte de ejercer o práctica de la medicina, las normativas, responsabilidades y derechos, y el efecto sobre la carga de trabajo.

Un futuro digital seguro

Aún está por ver si los escribas ambientales son la panacea para la sobrecarga de trabajo de los médicos de cabecera, pero parece poco probable, dado que las presiones no se limitan a la toma de notas. No obstante, su rápida adopción no es de extrañar en un contexto en el que el Gobierno del Reino Unido hace hincapié en las tecnologías de inteligencia artificial como posible solución a la crisis de los servicios públicos, junto con el oportunismo comercial. No se trata de si se utilizarán, sino de cómo garantizar que su implementación respalde todos los ámbitos de la asistencia sanitaria de calidad, sin comprometerlos.

| Mensajes clave El uso de escribas ambientales o digitales por parte de los médicos generales está aumentando rápidamente y se considera que tiene el potencial de reducir la carga de trabajo administrativo. Los escribas también tienen el potencial de tener efectos no deseados en la calidad de la atención y la toma de decisiones clínicas. Se carece de pruebas sobre los efectos indirectos y a largo plazo de los escribas ambientales. También es necesario aclarar las responsabilidades y los derechos que conlleva el uso de escribas ambientales. Hasta que se disponga de pruebas, los médicos deben utilizar la tecnología con diligencia y precaución. |

Adenda, fragmento de la editorial: Bravo Toledo R. Atención primaria y transformación digital. Aten Primaria. 2025 Aug 8;57(11):103360. doi: 10.1016/j.aprim.2025.103360.

El pionerismo o adanismo 7, o la costumbre de gestores y políticos de presentar proyectos como novedosos e innovadores, dando por sentado su éxito y como si nadie los hubiera realizado anteriormente, es un fenómeno demasiado presente en cuanto se habla de nuevas tecnologías y TD. Un ejemplo relevante es la reciente implantación de sistemas de escribientes médicos digitales en diversos servicios sanitarios autonómicos 8. Estas aplicaciones, basadas en inteligencia artificial generativa, automatizan la redacción de notas clínicas a partir de la conversación médico-paciente y las versiones más actuales superan ampliamente la simple transcripción 9. Si bien han demostrado utilidad en países como Estados Unidos, donde la documentación clínica rigurosa es imprescindible, su adopción en la atención primaria española siembra una serie de dudas. La ausencia previa de la figura del “medical scribe”, al cual estas aplicaciones sustituyen, la escasa valoración de una documentación clínica detallada en la AP española, sumadas a deficiencias en los actuales historiales electrónicos, sugieren la necesidad de profundas adaptaciones tecnológicas y culturales antes de lograr que estos sistemas tengan un impacto significativo.

La recogida de datos está en el mismo corazón de la asistencia clínica; se facilitan muchas de las actividades relacionadas con la atención al paciente. Estos datos están anonimizados y custodiados, suponemos, por la sanidad pública, pero estas garantías se han visto demasiadas veces quebradas, como para pensar que son inquebrantables. Las nuevas propuestas de IA suponen una amenaza a la confidencialidad, ya que ya no sería necesario acceder a los registros clínicos, ni siquiera contar con la complicidad del médico que transcribe; bastaría con tener acceso, por ejemplo, a las conversaciones grabadas para disponer de una información que se puede utilizar de muy diversas maneras, no relacionadas precisamente con la salud. La ausencia de una planificación adecuada en la transformación digital puede conducir a la aparición de la brecha digital, en tanto en cuanto ocasiona las desigualdades en el acceso, el uso y las habilidades en relación con las TIC entre distintos grupos de personas 10.

Por último, es sorprendente la falta de regulación de todos los proyectos relacionados con las nuevas tecnologías. Al contrario que otras intervenciones sanitarias como medicamentos o dispositivos médicos, a los proyectos de transformación digital no se les pide, en nuestro país, que sean eficaces y eficientes y mucho menos efectivos: podríamos decir que no hay evidencias salvo proyectos piloto trucados y un ensimismamiento general digno del cervantino retablo de las maravillas.

Evaluación de modelos de lenguaje en IA médica: Importancia del estándar de referencia

adenda a Hacia una inteligencia artificial de diagnóstico conversacional

comentarios a adicionales a la entrada Hacia una inteligencia artificial de diagnóstico conversacional

Por Julio Bonis Sanz. Médico de familia + MBA + Ingeniero de IA PLN

Ojo, que el problema como siempre, es de fundamentos.

Lo más relevante en este estudio, y en otros, es el diseño del estudio y lo que ese diseño implica.

Es un diseño elaborado por ingenieros informáticos de Google (es decir clase media alta de San Francisco) asesorados por expertos clínicos (me apuesto a que especialistas de hospital de renombre).

El meollo del asunto es la definición del estándar de referencia o gold standard (el que se asume que clasifica de forma válida a los sujetos respecto a la presencia o ausencia de una condición clínica)

Cuando quieres evaluar cómo de buenas son los textos generados por un modelo de lenguaje (listas de diagnósticos, recomendaciones, etc) tienes que decidir cual es el texto «correcto» sobre el cual compararlo. Por ejemplo si le pides al modelo «dame los 10 diagnósticos por orden de más a menos probable» para saber cómo de bueno es, tienes que definir cual es el diagnostico correcto. Así puedes ver en qué posición incluyó el modelo el diagnóstico correcto y compararlo con la posición en la que lo incluyó el médico de familia. Pues bien, los ingenieros de google decidieron que el gold standard (el que juzga cómo de correcto o incorrecto el razonamiento clínico de la IA o del médico de familia) es la opinión de ¡un especialista!

El propio hecho de que evaluen el modelo viendo si elabora un diagnostico correcto (como si toda consulta de AP tuviese que concluir con un diagnóstico específico al final de la misma) revela su marco conceptual. Además los ingenieros decidieron qué especialista era el «adecuado». Uno de los problemas está, claro, en qué especialista elegir como gold standard para una paciente de 65 años que consulta en el centro de salud por «un mareillo que me da por las tardes» (¿cardiólogo? ¿Neurólogo? ¿Psiquiatra? ¿Digestivo?)

Naturalmente si como especialista eres el gold standard ninguna IA te va a poder superar, para eso eres el gold standard. Por eso digo que nada cambia. Lo que vemos en este (y otros estudios) es la asunción de que los especialistas son los que saben lo que hay que hacer, y pueden dar lecciones a los medfams sobre lo mal que lo hacen. Es la asunción del médico de familia como «especialista de segunda», que no aporta valor diferencial alguno en cuanto a abordaje especifico de la presentación clínica «indiferenciada» en etapas iniciales de la historia natural de la enfermedad, manejo de la incertidumbre, integración de los valores personales del paciente en la toma de decisiones (valores que se conocen a través de la relación longitudinal), sino simplemente una solución de «bajo coste» al hecho de no poder tener a un dermatólogo atendiendo todos los granos o a un cardiólogo atendiendo todas las palpitaciones o hipertensiones de la población.

La Atención Primaria está en crisis, porque nuestros políticos, dirigentes y resto de especialistas creen y actúan como si la función de la Atención Primaria fuese atender problemas menores, para que los pacientes no molesten en el hospital.

Julio Bonis y Rafael Bravo en los constipadillos

Podrían haber decidido que el gold standard fuera un panel de médicos de familia con más de 10 años de experiencia (por ejemplo) pero no, decidieron que fuese un endocrinólogo quien juzgara si la IA y el medfam habían hecho bien su trabajo al manejar un caso de paciente con glucemias mal controladas.

El diseño de este (y otros estudios) lo que demuestra es que la IA piensa más como un especialista de hospital que como un médico general (es decir la IA se aproxima más al gold standard que el médico general). Lo que subyace es la idea de que lo deseable sería que los pacientes pudiesen acceder directamente al especialista. Si la IA maneja los problemas cardiológicos mejor que un MedFam (a juicio de un cardiólogo) y los problemas neurológicos mejor que un MedFam (a juicio de un neurólogo) entonces mejor pongamos a la IA a pasar consultas de primaria porque sería como poder darles acceso directo a los distintos especialistas. Ninguno de los ingenieros de Google ni quienes les asesoran o financian comprenden el papel de filtro, el concepto de prevención cuaternaria, etc, etc. Si lo comprendieran usarían gold standards distintos para los distintos niveles asistenciales y estarían elaborando modelos específicos entrenados para elaborar razonamientos clínicos como un médico de atención primaria (no como un especialista de hospital).

Hacia una inteligencia artificial de diagnóstico conversacional

Por Julio Bonis Sanz. Médico de familia + MBA + Ingeniero de IA PLN

En el repositorio arXiv investigadores de Google han publicado hace tres días un artículo titulado: «Hacia una IA de diagnóstico conversacional» (Towards Conversational Diagnostic AI)

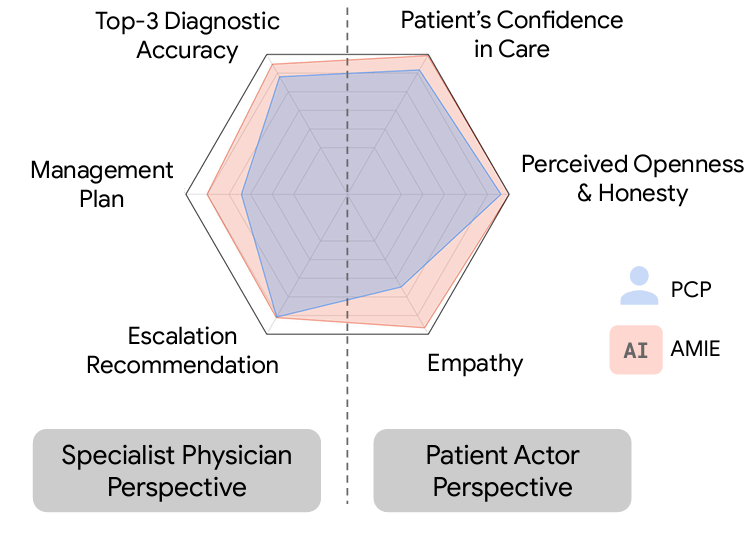

Diseño del estudio: en un estudio aleatorizado, doble ciego cruzado de consultas basadas en texto. Se elaboraron 149 escenarios clínicos que fueron representados por actores entrenados, al estilo de un Examen Clínico Objetivo Estructurado (ECOE). Los actores interaccionaban exclusivamente vía chat de texto, bien con 20 médicos de atencion primaria (10 canadienses y 10 indios) con amplio rango de experiencia (entre 3 y 30 años), o bien con un modelo de lenguaje (estilo chatGPT) denominado AMIE (Articulate Medical Intelligence Explorer).

Se pidió a los médicos y a la IA elaborar un listado de los 10 diagnósticos más probables ordenados de más a menos probables. Además se evaluaron multitud de dimensiones de la entrevista clínica; desde aspectos relacionados con la empatía, presencia del diagnóstico correcto entre el listado de diagnóstico, si el tratamiento recomendado era apropiado, si las pruebas complementarias solicitadas eran apropiadas, si las derivaciones al especialista eran adecuadas, etc.

Esta evaluación se realizó mediante dos tipos de cuestionarios: unos de satisfacción validados, rellenados por los actores (para las dimensiones de empatía) y otros cuestionarios rellenados POR MÉDICOS ESPECIALISTAS seleccionando la especialidad según el caso, a juicio de los investigadores (ingenieros informáticos de Google) para evaluar la calidad clínica. Se media por tanto esta última y , pero también la calidad empática del encuentro.

Resultados: La IA obtuvo mejores resultados en todas las dimensiones (clínicas y empáticas) que los médicos de atención primaria… a juicio de médicos especialistas.

Conclusión: La IA puede cambiar ciertas cosas, pero hay otras que no van a cambiar. Ninguno de los investigadores (ingenieros de Silicon Valley) ni ninguno de los médicos y expertos que andan estos días discutiendo las limitaciones del estudio (que las tiene) ha caído en la cuenta de que a lo mejor el criterio de un médico especialista no es lo mejor para valorar lo que ocurre en una consulta de atención primaria. Se considera una obviedad que el juicio clínico del médico especialista es el gold standard que por pura epistemología se asume que nunca se podrá superar (como mucho igualar).

Interpretación alternativa: Los resultados del estudio sugieren que la IA se comporta, en cuanto a sus decisiones clínicas, más como un especialista que como un médico de atención primaria. Esto tiene sentido pues los modelos de lenguaje están entrenados con el contenido encontrado en internet (incluido PubMed) y eso es lo que replican al generar textos.

Por tanto no sería descabellado pensar que los primeros susceptibles de ser sustituidos deberían ser los médicos especialistas y no los generalistas. Sin embargo eso tampoco lo veremos.

PD: como dato curioso se pidió a los especialistas indicasen si el «médico de familia/IA» había producido una «alucinación» (se define como un contenido sin sentido, erróneo o inventado por un modelo de lenguaje). Según se puede ver en el artículo publicado los especialistas (que evaluaban los chats sin saber si eran generados por humanos o una IA) encontraron alucinaciones en un 10% de los casos en la IA… y en un 15% de los médicos de familia. Corolario: Conviene no ir puestos de LSD al centro de salud.

Towards Conversational Diagnostic AI

Resumen canónico : En el corazón de la medicina se encuentra el diálogo médico-paciente, en el que una hábil anamnesis allana el camino para un diagnóstico preciso, un tratamiento eficaz y una confianza duradera. Los sistemas de Inteligencia Artificial (IA) capaces de dialogo diagnóstico podrían aumentar la accesibilidad, la coherencia y la calidad de la atención. Sin embargo, aproximarse a la experiencia de los médicos es un gran reto pendiente. Presentamos AMIE (Articulate Medical Intelligence Explorer), un sistema de IA basado en un modelo de lenguaje amplio (LLM) optimizado para el diálogo diagnóstico.

AMIE utiliza un novedoso entorno simulado basado en el juego automático con mecanismos de retroalimentación automatizados para escalar el aprendizaje a través de diversas enfermedades, especialidades y contextos. Diseñamos un marco para evaluar ejes de rendimiento clínicamente significativos, como la elaboración de la historia clínica, la precisión diagnóstica, el razonamiento de gestión, las habilidades de comunicación y la empatía. Comparamos el rendimiento de los AMIE con el de los médicos de atención primaria (MAP) en un estudio aleatorizado, doble ciego cruzado de consultas basadas en texto con actores pacientes validados al estilo de un Examen Clínico Objetivo Estructurado (ECOE). El estudio incluyó 149 escenarios de casos clínicos de profesionales de Canadá, el Reino Unido y la India, 20 MAPs para comparar con AMIE y evaluaciones por parte de médicos especialistas y los actores que actuaban como pacientes.

AMIE demostró una mayor precisión diagnóstica y un rendimiento superior en 28 de 32 ejes según los médicos especialistas y en 24 de 26 ejes según los pacientes actores. Nuestra investigación tiene varias limitaciones y debe interpretarse con la debida cautela. Los médicos se limitaron a un chat de texto sincrónico poco familiar que permite interacciones a gran escala entre el AMIE y el paciente, pero que no es representativo de la práctica clínica habitual. Aunque es necesario seguir investigando antes de que AMIE pueda trasladarse a entornos reales, los resultados representan un hito hacia la IA de diagnóstico conversacional.

El mundo en dos décadas

Por Antonio Orbe

Es imprescindible reflexionar sobre qué cambios vendrán (y serán muchos) en las próximas dos décadas.

He escrito UNA MIRADA AL FUTURO. Inteligencia artificial, abundancia, empleo y sociedad para llenar en parte un clamoroso vacío sobre la influencia que la tecnología tendrá en el futuro próximo. Aparecen con creciente frecuencia en los medios noticias sobre si los robots nos quitarán el empleo o si la inteligencia artificial dominará el planeta. Pocas de ellas están bien documentadas, pero al menos tienen la virtud de suscitar la atención sobre el tema. Peor aún es el caso de la política en el que el tema ni siquiera se menciona.

He escrito UNA MIRADA AL FUTURO. Inteligencia artificial, abundancia, empleo y sociedad para llenar en parte un clamoroso vacío sobre la influencia que la tecnología tendrá en el futuro próximo. Aparecen con creciente frecuencia en los medios noticias sobre si los robots nos quitarán el empleo o si la inteligencia artificial dominará el planeta. Pocas de ellas están bien documentadas, pero al menos tienen la virtud de suscitar la atención sobre el tema. Peor aún es el caso de la política en el que el tema ni siquiera se menciona.

¿Crees que la inteligencia artificial es muy lista o por el contrario piensas que es muy tonta?

La inteligencia artificial general IAG concebida como un ente capaz de solucionar cualquier problema es ciencia ficción y su amenaza, en palabras de Andrew Ng, ingeniero de Google, profesor de Stanford, jefe científico de Baidu (el buscador chino) y cofundador de la empresa de cursos online Coursera, es como como preocuparse de la sobrepoblación en Marte. El principal problema que la tecnología ha supuesto durante siglos es su amenaza contra el empleo. Por ejemplo, hay tres millones y medio de camioneros en Estados Unidos. Creo que necesitamos que los líderes gubernamentales y empresariales hablen sobre esto y pienso que el énfasis en los malvados robots asesinos es una distracción innecesaria”.

La inteligencia artificial es más bien como un ejército de hormigas que están en todas partes, ayudadas por el ubicuo teléfono móvil. Pequeñas aplicaciones de inteligencia artificial van ocupando un espacio cada vez mayor.

La tecnología destruye empleos, siempre ha sido así. La economía clásica dice que los empleos destruidos en un sector se crearán en otro: de la agricultura a la industria y de esta a los servicios. Pero no está nada claro que esto siga siendo así. ¿Hablamos de los empleos de una empresa como Whatsapp con 50 empleados? Dicen que por cada empleo que se crea en Amazon se destruyen cuatro en la economía tradicional. Amazon, una empresa que emplea miles de robots. ¿Y China? La robotización de la segunda economía del mundo es acelerada.

Pero la tecnología trae también la abundancia y el bienestar. Nadie lo diría viendo las noticias, pero el mundo mejora deprisa. La esperanza de vida, la lucha contra las pestes del pasado (incluyendo la malaria que ha descendido un 40% desde 2000), la educación, la democracia, o la violencia y las guerras mejoran.

El trabajo es odiado y deseado. Pero en la actualidad es deseado casi exclusivamente por los ingresos que reporta. La mayoría de la gente detesta su trabajo y es sencillo ponerse en el lugar de los muchos trabajos que la gente realiza solo por dinero.

Si las máquinas hacen el trabajo, los propietarios de estas se enriquecen y los asalariados se empobrecen: la desigualdad aumenta en el mundo. Algunas ideas como la renta básica universal son una propuesta a considerar.

Mientras tanto estamos educando a los jóvenes para un mundo que no existirá. Pretender que van a tener un empleo como los de antes es generar una enorme frustración.

¿Estamos preparados para el futuro?