OpenAI descubre que la asistencia sanitaria tiene problemas y se ofrece como solución.

Tras la publicación de un documento de OpenAI sobre inteligencia artificial (IA) y asistencia sanitaria. John Ferguson, cirujano americano radicado en Hawaii, hace una lúcida y mordaz crítica del documento en particular y del empeño de las compañías punteras de IA para introducirse en el campo de la asistencia sanitaria. Gracias a Julio Bonis, que nos avisó sobre esta entrada, y al generoso permiso del Dr Ferguson traducimos su entrada original de LinkedIn.

Traduccion de OpenAI Discovers Healthcare Has Problems, Offers to Be the Solution por John Ferguson, MD, FACS President-Elect, ABFCS | Surgeon Solving AI Hallucination in High-Stakes Domains | EdAI CEO | Co-Chair Written Exam Committees |

OpenAI descubre que los servicios de atención sanitaria tienen problemas y se ofrece como solución. o: Cómo citar tu propia precisión del 31% como un «diagnóstico preciso»

OpenAI acaba de publicar un documento de 18 páginas titulado «La IA como aliada de la asistencia sanitaria». Lo he leído para que no tengas que hacerlo. Mi tensión arterial está bien. La he comprobado yo mismo, sin ChatGPT, porque tengo 10 000 millones de neuronas sensoriales y un tensiómetro.

Te lo resumo: los estadounidenses están preocupados por la asistencia sanitaria. La asistencia sanitaria es cara. Los hospitales rurales están cerrando. La gente envía mensajes a ChatGPT sobre seguros de salud. Por lo tanto, la IA debería encargarse del diagnóstico.

Si ese salto lógico te ha dejado atónito, es que estás prestando atención.

El juego de los números

OpenAI quiere que sepas que 40 millones de personas utilizan ChatGPT cada día para preguntas sobre salud. Uno de cada cuatro usuarios pregunta sobre salud cada semana. Casi 600 000 mensajes provienen de reguniones geográficas consideradas «desiertos hospitalarios».

¿Sabes qué tiene también mucho tráfico? WebMD. Las secciones de comentarios de los blogs de madres. Ese tipo de YouTube que cree que se puede curar la diabetes con canela.

El volumen de trafico no equivale a calidad.

Pero aquí es donde se pone interesante. Escondido en la página 10, OpenAI cita OpenEvidence, una plataforma construida usando sus modelos, como apoyo para «diagnósticos precisos verificados a partir de guías de práctica clínica».

OpenEvidence. El sistema de 210 millones de dólares con 400 000 médicos usuarios. 100 % de acierto en los exámenes para una autorización para practicar la medicina (medical licensing exams).

31-41% de acierto en las preguntas que regulan el acceso a las distintas especialidades.

Lo probé yo mismo. Les hice un examen a libro abierto, solo con preguntas en las que tenían acceso directo al material de referencia. Sin asimetría de información. Con todas las ventajas.

Obtuvieron una puntuación inferior al umbral de aprobado.

Próximamente compartiré la metodología y los resultados completos. Pero «preciso» no es la palabra que yo utilizaría para describirlos.

El señuelo y el cambio

El documento realiza un truco de prestidigitación que ya he visto antes:

Paso 1: Establecer un problema real. «Los seguros son confusos. Los hospitales rurales están cerrando. La gente no puede conseguir citas».

Paso 2: Mostrar cómo la IA ayuda con ese problema. «¡ChatGPT ayuda a la gente a entender sus facturas médicas! ¡A entender las condiciones de los seguros! ¡A prepararse para las citas médicas!».

Paso 3: Pasar a un problema completamente diferente. «Y además realiza diagnósticos precisos».

Esto es como decir: «La gente tiene hambre. Los food trucks son populares. Por lo tanto, déjame operarte de apendicitis desde un food truck.

El problema de acceso a la atención sanitaria es real. La IA que ayuda a la gente a descifrar la jerga de los seguros médicos es realmente útil. Pero «explicar la prima y condiciones de tu seguro de salud» y «diagnosticar tu dolor de pecho» no son la misma cosa, tienen el mismo perfil de riesgo ni la misma estructura de responsabilidad.

OpenAI lo sabe. Cuentan con que tú no te des cuenta.

El complejo industrial de las anécdotas

Cada pocas páginas, una historia conmovedora. La madre de Ayrin en Indonesia. La reclamación al seguro de Rich Kaplan. El Dr. Albers en la Montana rural.

¿Sabes qué tienen en común estas historias? La IA tenía razón.

¿Sabes qué falta? Todas las historias en las que no la tenía.

La madre de Ayrin se tomó la tensión arterial y era peligrosamente alta. ChatGPT dijo que era una crisis hipertensiva y la prueba lo confirmó. Estupendo.

Pero, ¿qué pasa con la madre cuya tensión arterial era normal pero ChatGPT dijo que era una crisis de todos modos? ¿O aquella en la que ChatGPT dijo «probablemente fatiga» y era un derrame cerebral?

Esas historias no aparecen en el PDF.

Se trata de un sesgo de supervivencia con presupuesto de marketing.

La petición regulatoria

En la página 14, OpenAI nos dice lo que realmente quiere:

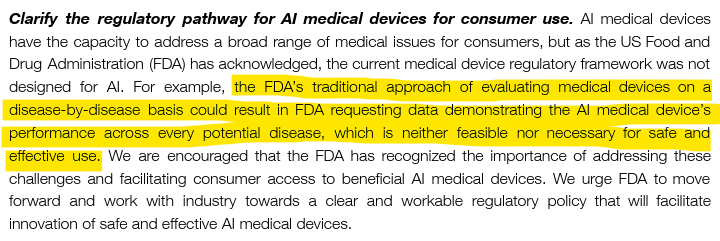

«El enfoque tradicional de la FDA de evaluar los dispositivos médicos enfermedad por enfermedad podría dar lugar a que la FDA solicite datos que demuestren el rendimiento del dispositivo médico con IA para todas las enfermedades, lo cual no es factible ni necesario para un uso seguro y eficaz».

Traducción: No nos obliguen a demostrar que funciona.

He aquí una contrapropuesta: si su sistema afirma ofrecer un «diagnóstico preciso», demostrar la precisión no es pedir demasiado.

Demuestro que puedo operar antes de que me dejen operar. Demuestro que sé medicina antes de que me dejen colegiarme. Tengo un seguro de responsabilidad civil profesional porque mis decisiones tienen consecuencias.

OpenAI quiere que se implemente la IA diagnóstica sin validación enfermedad por enfermedad porque «no es factible».

¿Sabes qué más no es factible? Explicarle a una familia por qué la IA hablaba de forma convincente pero se equivocó con respecto a su hijo.

La sección que falta

Esto es lo que no aparece en las 18 páginas:

Qué ocurre cuando ChatGPT se equivoca. Quién es responsable cuando ChatGPT se equivoca. Con qué frecuencia se equivoca ChatGPT. Alguna mención a un mecanismo para decir «No lo sé». Algún reconocimiento de que «No lo sé» debería ser una opción.

El documento menciona que «la fiabilidad mejora cuando las respuestas se basan en el contexto específico del paciente».

Es una forma curiosa de decir «no es fiable cuando no lo es».

No se habla de la incertidumbre. No se habla de las alucinaciones. No se reconoce que los LLM son arquitectónicamente incapaces de reconocer los límites de su propio conocimiento.

Están vendiendo un sistema que no puede decir «no lo sé» para su uso en un ámbito en el que «no lo sé» es a menudo lo más importante que se puede decir.

La distinción que no hacen

La IA aplicada a la gestión sanitaria optimiza los sistemas, las poblaciones y los flujos de trabajo. Programación. Facturación. Comprensión de las pólizas de los seguros de salud. Asignación de recursos.

La IA médica toma decisiones sobre pacientes individuales. Diagnóstico. Tratamiento. Pronóstico.

No son lo mismo.

La IA aplicada a la gestión sanitaria puede tolerar índices de error. Si un algoritmo de asignación de citas médicas falla el 5 % de las veces, los pacientes se enfadan. Se puede arreglar.

La IA médica no puede. Si un sistema de diagnóstico se equivoca entre el 60 y el 70 % en casos de una subespecialidad, como es el caso de OpenEvidence, la gente sale perjudicada.

El documento de OpenAI confunde constantemente ambos conceptos. Las estadísticas se refieren a la gestión sanitaria (mensajes de seguros, acceso en zonas rurales). Las aspiraciones son médicas (diagnóstico, comprobación de guías, apoyo a la toma de decisiones clínicas).

El cebo es real. El cambio es peligroso.

¿Qué significa realmente «aliado»?

Un aliado conoce su papel. Un aliado apoya sin sustituir. Un aliado admite cuando algo le supera.

Un aliado no afirma ofrecer un «diagnóstico preciso» al 31 %.

Un aliado no presiona para que haya menos supervisión mientras celebra el uso clínico.

Un aliado no oculta los modos de fallo en los textos publicitarios.

Tengo un asistente de IA. Se llama TheDude. Está basado en Claude, con una arquitectura de control de contenido, y su característica principal es saber lo que no sabe.

Cuando TheDude llega al límite de su conocimiento validado, dice: «Tío, eso está fuera de mi ámbito de competencia».

Así es como suena un aliado.

La versión de OpenAI suena así: «Aquí tienes cuatro párrafos convincentes sobre las interacciones entre los cristales de hielo de metano y el viento solar».

Conclusión

OpenAI ha redactado un documento de 18 páginas que:

- Identifica problemas reales (acceso, coste, complejidad).

- Muestra cómo la IA ayuda en versiones de bajo riesgo (aseguradoras, navegación a través del sistema sanitario).

- Extrapolando a aplicaciones clínicas de alto riesgo sin validación.

- Cita un sistema con una precisión del 31 % como «preciso».

- Presiona para que haya menos supervisión regulatoria.

- No incluye ningún debate sobre la responsabilidad o en dónde puede fallar.

- Nunca menciona la posibilidad de decir «no lo sé».

Esto no es un aliado de la sanidad. Es un documento de marketing con bata blanca.

Los verdaderos aliados conocen sus límites. Los verdaderos aliados no te engañan sobre su precisión. Los verdaderos aliados entienden que, en medicina, el exceso de autoconfianza sin pericia mata a la gente.

40 millones de personas al día hacen preguntas sobre salud a ChatGPT.

¿Cuántas de ellas saben lo del 31 %?

El autor es un cirujano que probó OpenEvidence por sí mismo, cuyo asistente de IA se mantiene dentro de sus límites, y que cree que «preciso» debería significar algo más que «tenemos un PDF». Metodología completa próximamente.

Volvemos a las lindas polillitas atraídas por los faros de los coches.

Mira la competencia que se montó entre servicios de salud hace unos meses, ya todos callados, porque alguien ha visto forrado su lomo con los dictáfonos IA, que nos lo iban a resolver todo.

Tampoco, entonces, nos dijeron el % de error, el trabajo que traía decodificar las tontás resumidas de una conversación a saltos del paisano y su médico, al que no le hacía falta más palabras para saber lo que precisaba el mismo.

A ver qué se les ocurre a los ineptos este trimestre.

ART

Me gustaMe gusta