Cuando los pacientes llegan con respuestas

Traducido de When Patients Arrive With Answers por Sundar, Kumara Raja en JAMA 2025; 334; (8): 672-673. doi:10.1001/jama.2025.10678

…No es nada nuevo que los pacientes lleguen con información. Desde hace mucho tiempo traen recortes de periódico, resultados de búsquedas en Internet o notas de conversaciones con familiares. Las posibles soluciones que se transmiten en los hilos de WhatsApp han sido en ocasiones una parte integral de mis conversaciones clínicas

La búsqueda de información fuera del ámbito sanitario siempre ha formado parte del panorama asistencial.

Pero hay algo en este momento que parece diferente. La inteligencia artificial generativa (IA), con herramientas como ChatGPT, ofrece información de una manera que parece única, conversacional y personalizada. Su tono invita al diálogo. Su confianza implica competencia. Cada vez más, los pacientes traen a mi consulta conocimientos generados por la IA y, a veces, se sienten lo suficientemente seguros como para cuestionar mi evaluación y mi plan.

Había oído que estas herramientas eran útiles, pero solo comprendí su atractivo después de utilizarlas yo mismo. Estudios recientes han respaldado esta afirmación: los grandes modelos de lenguaje (LLM) muestran una sorprendente fortaleza en el razonamiento y el tono relacional. Después de verlo de primera mano, mi reacción fue sencilla: «Vaya, entiendo por qué a mis pacientes les gusta».

Sin embargo, comparar los LLM con los médicos parece intrínsecamente injusto.

[Comentario: como otras comparaciones, en este ejemplo o este]

Los médicos suelen trabajar bajo presión, con visitas apresuradas y bandejas de entrada desbordadas, ya que los sistemas de salud exigen productividad y rendimiento. Mi preocupación es que la investigación compara a los médicos, que no tienen el lujo de rendir al máximo en sistemas saturados, con los recursos inagotables de la IA generativa. No es una lucha justa, pero es la realidad. Creo que los pacientes pueden buscar respuestas claras, pero, sobre todo, quieren sentirse reconocidos, tranquilos y verdaderamente escuchados. Por desgracia, bajo el peso de las exigencias contrapuestas, eso es lo que a menudo se me escapa, no solo por las limitaciones sistémicas, sino también porque soy humano.

A pesar de las capacidades de la IA generativa, los pacientes siguen acudiendo a mí. Las herramientas que utilizan suelen ofrecer sugerencias fiables, pero al final se remiten a alguna versión de la conocida advertencia: «Consulte a un profesional médico». La responsabilidad de la atención sigue recayendo en el médico. Tanto en términos de responsabilidad civil, quién asumirá la culpa si algo sale mal o alguien resulta perjudicado, como en términos de responsabilidad, quién dará las órdenes para los planes de diagnóstico y las prescripciones de atención. Los médicos siguen siendo los guardianes (gatekeepers). En la práctica, esto significa atender las solicitudes de los pacientes, como una prueba de mesa basculante para los mareos intermitentes, pruebas que no son inusuales, pero que pueden no ser adecuadas en una etapa específica de la atención. Me encuentro explicando conceptos como el sobrediagnóstico, los falsos positivos u otros riesgos de pruebas innecesarias. En el mejor de los casos, el paciente entiende las ideas, aunque es difícil identificarse con ellas cuando uno es la persona que experimenta los síntomas. En el peor de los casos, parezco desdeñoso. No hay ninguna función que le diga a ChatGPT que los médicos carecen de acceso rutinario a las pruebas de mesa basculante o que las citas para ecocardiogramas se retrasan debido a la escasez de personal. Tengo que llevar esas limitaciones a la sala de exploración mientras sigo tratando de mantener la confianza.

Cuando hablo con estudiantes de medicina, noto que se está infiltrando un tipo diferente de paternalismo. Y lo he detectado en mi monólogo interior, aunque no lo diga en voz alta. La obsoleta frase «Probablemente lo hayan buscado en WebMD y crean que tienen cáncer» se ha transformado en una nueva frase, igual de desdeñosa: «Probablemente lo hayan buscado en ChatGPT y vayan a decirnos qué recetar». A menudo refleja una actitud defensiva por parte de los médicos, en lugar de un compromiso genuino, y conlleva un mensaje implícito: nosotros seguimos sabiendo más. Es una actitud que corre el riesgo de erosionar la sagrada y frágil confianza entre los médicos y los pacientes. Refuerza la sensación de que no estamos «en el mismo barco» que nuestros pacientes y que, en realidad, estamos actuando como guardianes en lugar de como socios. Irónicamente, esa es a menudo la razón por la que oigo a los pacientes recurrir a los LLM en primer lugar.

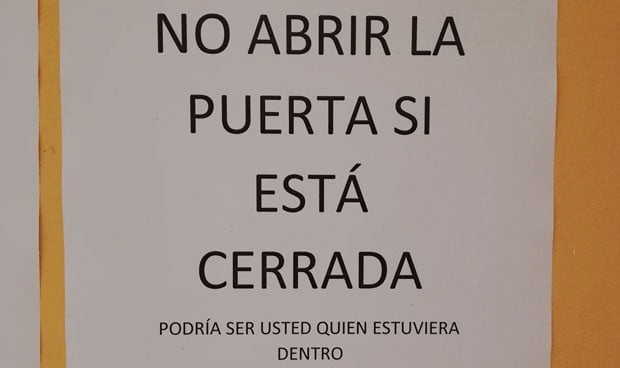

Una paciente dijo claramente: «Así es como puedo defenderme mejor». La palabra «defender» me llamó la atención. Es lo que se hace cuando se intenta convencer a alguien con más poder. Sé que los médicos siguen teniendo la última palabra a la hora de solicitar pruebas, derivaciones y planes de tratamiento, pero la palabra «defender» transmite la sensación de prepararse para una lucha. Cuando los pacientes se sienten ignorados, armarse de conocimientos se convierte en una estrategia para que se les tome en serio. Recuerdo vívidamente a otra paciente que, tras sufrir un aborto espontáneo, llegó con una serie de evaluaciones específicas que quería que se le realizaran. Su petición estaba cargada de dolor, rechazo previo y la silenciosa esperanza de que estar preparada pudiera finalmente llevarla a ser escuchada. No necesitó la estrategia habitual de lanzarse a una explicación sobre los falsos positivos, el sobrediagnóstico y las características de las pruebas. Desde la perspectiva de la paciente, me di cuenta de que todas las explicaciones cognitivas pueden sonar así: «Sigo sabiendo más que tú, independientemente de la herramienta que hayas utilizado, y voy a abrumarte con cosas que no entiendes». Lo que funcionó en ese momento fue muy diferente. Le dije: «Hablaremos de las opciones de pruebas. Pero primero, siento mucho tu pérdida. No puedo imaginar cómo te sientes. Quiero resolver esto con usted y hacer un plan juntos». Ese momento de reconocimiento fue lo que realmente abrió la puerta.

Nuestras funciones como médicos han cambiado constantemente desde mi formación. La atención centrada en el paciente y la colaboración formaban parte del léxico durante la carrera de medicina. Los médicos han evolucionado desde hace tiempo, pasando de ser expertos autoritarios a guías colaborativos, pero ahora el ritmo se está acelerando. La democratización del conocimiento médico exige a los médicos, más que nunca, una humildad relacional como prioridad.

Ver las visitas informadas por la IA como oportunidades para un diálogo más profundo en lugar de amenazas a la autoridad clínica puede parecer una aspiración, pero refleja un cambio necesario. Los retos prácticos son reales. Los pacientes pueden acudir con expectativas poco realistas o citar recomendaciones que no se ajustan a las directrices basadas en la evidencia o que son poco prácticas para un determinado entorno de recursos. Estos momentos no son nuevos. Durante mucho tiempo hemos tenido que explicar por qué no siempre es necesaria una resonancia magnética para el dolor de espalda o por qué los antibióticos no ayudan a una infección viral. Sabemos que la solución no es cerrar estas conversaciones, sino abordarlas con paciencia y curiosidad. La medicina siempre ha dependido de las relaciones. Lo que está cambiando es cómo comienzan esas relaciones y lo que los pacientes aportan. Si los pacientes se arman de información para ser escuchados, nuestra tarea como médicos es recibirlos con reconocimiento, no con resistencia. Al hacerlo, preservamos lo que siempre ha hecho humana a la medicina: la voluntad de compartir juntos el significado, la incertidumbre y la esperanza.

Está muy bien el paper. Yo si me viese en esa situación cogería al paciente y abriría chatGPT delante suya, que responderá X.

Entonces le preguntas al LLM que si está seguro de lo que ha dicho, y seguramente el chatGPT se va a disculpar por el error y te va a recomendar una cosa diferente. Así el paciente entiende que el ChatGPT tampoco está seguro realmente de lo que dice (aunque genere tokens de una forma que parece que está sentando cátedra).

Me gustaMe gusta

Tras leer esto,

https://www.nejm.org/doi/full/10.1056/NEJMra2503232

uno concluye que hasta para los médicos (especialmente para los jóvenes) y estudiantes de medicina es, digamos, «peligrosa» la IA para diagnósticos. Es como darle una calculadora a un niño de 9 – 10 años que apenas acaba de aprender a hacer cuentas a mano y decirle que no «pierda» el tiempo haciéndolas a mano cuando existe esa calculadora que le «ahorra» tiempo. Imagínense lo «peligrosa» que puede llegar a ser para el general de los pacientes. En cualquier caso, estamos abocados a ello y habrá que lidiar ese toro a medida que vaya viniendo.

Juan Simó (Pamplona)

Me gustaMe gusta